Os deepfakes de vídeo já nos ensinaram a desconfiar do que vemos. Agora, os deepfakes de áudio elevam essa desconfiança a um novo patamar, fazendo-nos questionar a veracidade do que ouvimos. Será que o presidente realmente declarou guerra ao Canadá? Aquela voz ao telefone pedindo a senha do e-mail era mesmo a do seu pai?

Adicione mais uma preocupação existencial à lista de como a nossa própria arrogância pode nos levar à ruína. Nos tempos de Reagan, os únicos perigos tecnológicos reais eram a ameaça de guerras nucleares, químicas e biológicas.

Com o passar dos anos, nos deparamos com a possibilidade da gosma cinzenta da nanotecnologia e pandemias globais. Agora, temos os deepfakes – que nos fazem perder o controle sobre nossas aparências e vozes.

O que são Deepfakes de Áudio?

A maioria de nós já se deparou com um vídeo deepfake, no qual algoritmos de aprendizado profundo são empregados para substituir o rosto de uma pessoa pela de outra. Os mais bem feitos são incrivelmente realistas. Agora, chegou a vez do áudio. Um deepfake de áudio ocorre quando uma voz “clonada”, praticamente indistinguível da voz real de uma pessoa, é usada para gerar áudio sintético.

“É como um Photoshop para voz”, afirma Zohaib Ahmed, CEO da Resemble AI, sobre a tecnologia de clonagem de voz de sua empresa.

Entretanto, trabalhos malfeitos no Photoshop são facilmente identificados. Uma empresa de segurança com quem conversamos revelou que as pessoas geralmente acertam se um deepfake de áudio é real ou falso em cerca de 57% das vezes – um resultado não muito diferente de um simples “cara ou coroa”.

Além disso, como muitas gravações de voz são provenientes de chamadas telefônicas de baixa qualidade (ou captadas em locais ruidosos), os deepfakes de áudio podem se tornar ainda mais difíceis de detectar. Quanto pior a qualidade do som, mais complicado se torna identificar os sinais que revelam que uma voz não é genuína.

Mas, afinal, por que alguém precisaria de um “Photoshop” para vozes?

O Apelo do Áudio Sintético

Na verdade, existe uma grande procura por áudio sintético. Segundo Ahmed, “o retorno sobre o investimento é muito imediato”.

Isso é particularmente evidente no campo dos jogos. Antigamente, a fala era o único elemento de um jogo que não podia ser criado sob demanda. Mesmo em títulos interativos com cenas com qualidade cinematográfica renderizadas em tempo real, as interações verbais com personagens não jogáveis sempre foram essencialmente estáticas.

Contudo, a tecnologia evoluiu. Os estúdios agora têm o poder de clonar a voz de um ator e usar mecanismos de conversão de texto em fala para permitir que os personagens falem qualquer coisa em tempo real.

Há também aplicações mais tradicionais em publicidade, tecnologia e suporte ao cliente. Nesses setores, o que importa é uma voz com som autenticamente humano, capaz de responder de forma personalizada e contextual sem qualquer intervenção humana.

As empresas de clonagem de voz também estão entusiasmadas com as aplicações médicas. É claro que a substituição de voz não é uma novidade na medicina – Stephen Hawking utilizou uma voz sintetizada robótica depois de perder a sua em 1985. No entanto, a clonagem de voz moderna promete algo ainda melhor.

Em 2008, a empresa de voz sintética CereProc devolveu a voz ao falecido crítico de cinema Roger Ebert depois que o câncer a levou. A CereProc tinha publicado uma página na web que permitia que as pessoas inserissem mensagens que seriam lidas na voz do ex-presidente George Bush.

“Ebert viu isso e pensou: ‘bem, se eles conseguiram copiar a voz de Bush, devem ser capazes de copiar a minha’”, disse Matthew Aylett, diretor científico da CereProc. Ebert então solicitou à empresa que criasse uma voz substituta, o que fizeram processando uma extensa biblioteca de gravações de voz.

“Foi uma das primeiras vezes que alguém fez isso e foi um verdadeiro sucesso”, comentou Aylett.

Nos últimos anos, várias empresas (incluindo a CereProc) têm trabalhado com a Associação ELA no Projeto ReVoice, com o objetivo de fornecer vozes sintéticas para pessoas que sofrem de ELA.

Como Funciona o Áudio Sintético

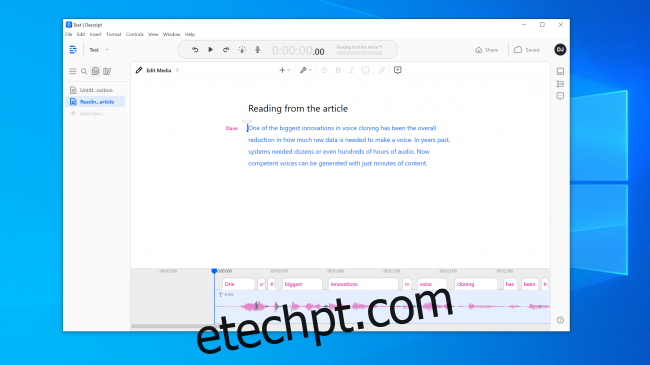

A clonagem de voz está em alta no momento, e diversas empresas estão desenvolvendo ferramentas nessa área. A Resemble AI e a Descript oferecem demonstrações online que qualquer pessoa pode experimentar gratuitamente. Basta gravar as frases que aparecem na tela e, em poucos minutos, é gerado um modelo da sua voz.

Podemos agradecer à Inteligência Artificial – especificamente aos algoritmos de aprendizado profundo – por sua capacidade de associar a fala gravada ao texto, para compreender os fonemas que compõem a sua voz. Em seguida, ela usa esses elementos básicos linguísticos para aproximar palavras que você não pronunciou.

A tecnologia básica já existe há algum tempo, mas, como Aylett observou, exigia um certo grau de intervenção manual.

“Copiar voz era um pouco como fazer pastelaria”, disse ele. “Era um processo um tanto complicado, com diversas etapas de ajuste manual para que funcionasse.”

Os desenvolvedores precisavam de grandes quantidades de dados de voz gravados para obter resultados aceitáveis. Mas, há alguns anos, as portas se abriram. A pesquisa na área de visão computacional se mostrou crucial. Os cientistas desenvolveram redes adversárias generativas (GANs), que pela primeira vez podem extrapolar e fazer previsões com base em dados existentes.

“Em vez de um computador analisar a imagem de um cavalo e afirmar ‘isto é um cavalo’, meu modelo agora pode transformar um cavalo em uma zebra”, disse Aylett. “Portanto, a explosão na síntese de fala é resultado do trabalho acadêmico em visão computacional.”

Uma das principais inovações na clonagem de voz foi a redução da quantidade de dados brutos necessários para criar uma voz. No passado, os sistemas precisavam de dezenas ou até centenas de horas de áudio. Hoje, vozes competentes podem ser geradas a partir de apenas alguns minutos de conteúdo.

O Medo de Não Poder Confiar em Nada

Essa tecnologia, juntamente com a energia nuclear, a nanotecnologia, a impressão 3D e o CRISPR, é ao mesmo tempo fascinante e assustadora. Afinal, já houve casos noticiados de pessoas sendo enganadas por clones de voz. Em 2019, uma empresa no Reino Unido alegou ter sido enganada por um deepfake de áudio em uma chamada telefônica, levando-a a transferir dinheiro para criminosos.

Não é preciso ir muito longe para encontrar falsificações de áudio incrivelmente convincentes. O canal do YouTube Síntese Vocal apresenta pessoas famosas dizendo coisas que nunca disseram, como George W. Bush lendo “In Da Club” de 50 Cent. E o resultado é impressionante.

Em outros cantos do YouTube, é possível ouvir diversos ex-presidentes, como Obama, Clinton e Reagan, fazendo rap do NWA. A música e os sons de fundo ajudam a mascarar algumas das falhas robóticas mais óbvias, mas mesmo nesse estado imperfeito, o potencial é evidente.

Experimentamos as ferramentas da Resemble AI e da Descript e criamos clones de voz. A Descript utiliza um mecanismo de clonagem de voz originalmente chamado Lyrebird e que se mostrou particularmente impressionante. Ficamos chocados com a qualidade. Ouvir a sua própria voz proferir frases que você sabe que nunca disse é perturbador.

É inegável que existe um componente robótico na fala, mas em uma audição casual, a maioria das pessoas não teria razões para suspeitar que se tratava de uma voz falsa.

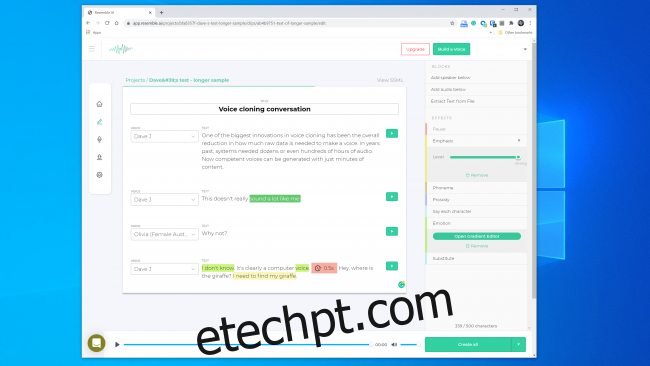

Tínhamos grandes expectativas em relação à Reemble AI. Ela oferece as ferramentas para criar uma conversa com diversas vozes, permitindo variar a expressividade, a emoção e o ritmo do diálogo. No entanto, não consideramos que o modelo de voz capturou as características essenciais da voz que usamos. Na verdade, seria difícil enganar alguém com ele.

Um representante da Reemble AI nos informou que “a maioria das pessoas fica impressionada com os resultados se fizerem tudo corretamente”. Criamos um modelo de voz duas vezes, com resultados semelhantes. Portanto, fica evidente que nem sempre é simples criar um clone de voz que possa ser usado para realizar um ataque digital.

Mesmo assim, o fundador da Lyrebird (agora parte da Descript), Kundan Kumar, acredita que já ultrapassamos esse limite.

“Em uma pequena porcentagem dos casos, isso já é uma realidade”, disse Kumar. “Se eu usar áudio sintético para mudar algumas palavras em um discurso, já será tão perfeito que você terá dificuldade em perceber a alteração.”

Podemos também presumir que essa tecnologia só tende a evoluir. Os sistemas precisarão de menos áudio para gerar um modelo, e processadores mais rápidos poderão construir esse modelo em tempo real. A IA mais inteligente aprenderá a adicionar nuances humanas mais convincentes e a dar ênfase na fala sem precisar de um exemplo para trabalhar.

Isso significa que podemos estar nos aproximando da ampla disponibilidade da clonagem de voz sem qualquer esforço.

A Ética da Caixa de Pandora

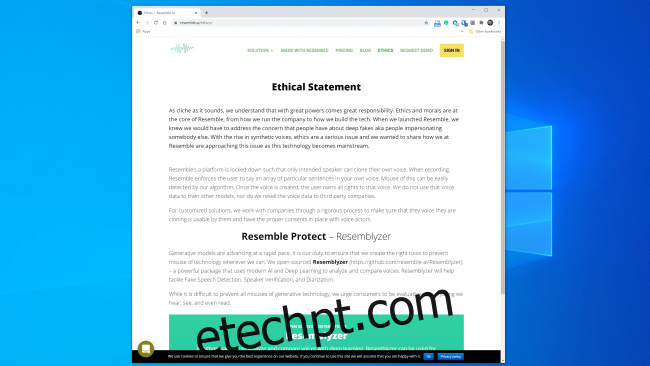

A maioria das empresas que atuam nessa área parece estar preparada para lidar com a tecnologia de forma segura e responsável. A Resemble AI, por exemplo, dedica uma seção inteira à “Ética” em seu site, e a seguinte declaração é encorajadora:

“Trabalhamos com as empresas através de um processo rigoroso para garantir que a voz que estão clonando possa ser utilizada por elas e que tenhamos o consentimento adequado dos dubladores.”

Da mesma forma, Kumar afirmou que a Lyrebird estava preocupada com o uso indevido desde o início. É por isso que agora, como parte da Descript, só permite que as pessoas clonem a própria voz. Na verdade, tanto a Resemble quanto a Descript exigem que os utilizadores gravem as suas amostras ao vivo para evitar a clonagem de voz sem consentimento.

É animador que os principais atores comerciais tenham estabelecido algumas diretrizes éticas. No entanto, é essencial lembrar que essas empresas não são as únicas a deter essa tecnologia. Já existem diversas ferramentas de código aberto disponíveis, sem regras a seguir. De acordo com Henry Ajder, chefe de inteligência de ameaças da Deeptrace, não é preciso ter conhecimentos avançados de programação para usá-la de forma inadequada.

“Grande parte do progresso nesse campo foi resultado de trabalho colaborativo em plataformas como o GitHub, usando implementações de código aberto de pesquisas acadêmicas publicadas anteriormente”, explicou Ajder. “Qualquer pessoa com um nível razoável de conhecimento em programação pode usar essas ferramentas.”

Profissionais de Segurança Já Viram Tudo Isso Antes

Os criminosos já tentavam roubar dinheiro por telefone muito antes da clonagem de voz se tornar uma realidade, e os especialistas em segurança sempre estiveram alertas para identificar e prevenir essas tentativas. A empresa de segurança Pindrop procura impedir fraudes bancárias verificando, com base no áudio, se a pessoa que está a ligar é quem afirma ser. Em 2019, a Pindrop afirma ter analisado 1,2 bilhão de interações de voz e evitado cerca de US$ 470 milhões em tentativas de fraude.

Antes da clonagem de voz, os fraudadores empregavam diversas outras técnicas. A mais simples era apenas ligar de outro lugar com informações pessoais sobre o cliente.

“Nossa assinatura acústica nos permite determinar se uma chamada realmente vem de um telefone Skype na Nigéria, analisando as características do som”, explicou o CEO da Pindrop, Vijay Balasubramaniyan. “Depois, podemos comparar essa informação com o fato de sabermos que o cliente usa um telefone da AT&T em Atlanta.”

Alguns criminosos também fizeram carreira usando ruídos de fundo para enganar os representantes dos bancos.

“Há um fraudador que chamamos de Homem do Frango, que sempre tinha galos no fundo”, disse Balasubramaniyan. “E há uma senhora que usava o choro de um bebê no fundo para convencer os operadores do call center de que ‘estava passando por um momento difícil’, buscando obter simpatia.”

E depois há os criminosos do sexo masculino que tentam invadir contas bancárias de mulheres.

“Eles usam tecnologia para aumentar a frequência da sua voz, de forma a parecerem mais femininas”, explicou Balasubramaniyan. Eles podem ter sucesso, mas “às vezes o software falha e eles acabam soando como Alvin e os Esquilos”.

É claro que a clonagem de voz é apenas o mais recente avanço nessa guerra cada vez mais complexa. As empresas de segurança já flagraram fraudadores usando áudio sintético em pelo menos um ataque de spear phishing.

“Quando o alvo certo é escolhido, o retorno pode ser enorme”, disse Balasubramaniyan. “Portanto, é lógico dedicar algum tempo para criar uma voz sintetizada da pessoa certa.”

É Possível Determinar se Uma Voz é Falsa?

Quando se trata de identificar uma voz falsificada, há boas e más notícias. A má notícia é que os clones de voz estão a ficar cada vez melhores. Os sistemas de aprendizado profundo estão mais inteligentes e a produzir vozes mais autênticas que exigem menos áudio para serem criadas.

Como se pode ver neste vídeo do Presidente Obama dizendo a MC Ren para depor, já chegamos a um ponto em que um modelo de voz de alta qualidade, meticulosamente construído, pode soar bastante convincente ao ouvido humano.

Quanto mais longo for o clipe de áudio, maior a probabilidade de você perceber que há algo errado. No caso de clipes mais curtos, no entanto, você pode não notar que é sintético, especialmente se não houver razões para questionar a sua veracidade.

Quanto mais nítida a qualidade do som, mais fácil é identificar sinais de deepfake de áudio. Se alguém estiver falando diretamente em um microfone com qualidade de estúdio, você poderá ouvir com atenção. Mas uma gravação de uma chamada telefônica com baixa qualidade ou uma conversa captada em um dispositivo portátil em um local ruidoso serão muito mais difíceis de avaliar.

A boa notícia é que, mesmo que os seres humanos tenham dificuldade em distinguir o real do falso, os computadores não têm as mesmas limitações. Felizmente, já existem ferramentas de verificação de voz. A Pindrop tem uma ferramenta que coloca sistemas de aprendizado profundo uns contra os outros. Ela usa ambos os sistemas para determinar se uma amostra de áudio corresponde à pessoa que deveria ser. Além disso, analisa se um ser humano seria capaz de emitir todos os sons presentes na amostra.

Dependendo da qualidade do áudio, cada segundo de fala contém entre 8.000 e 50.000 amostras de dados que podem ser analisadas.

“As características que normalmente procuramos são as restrições na fala resultantes da evolução humana”, explicou Balasubramaniyan.

Por exemplo, dois sons vocais possuem uma separação mínima possível entre si. Isso acontece porque não é fisicamente possível pronunciá-los mais rapidamente, devido à velocidade com que os músculos da boca e das cordas vocais conseguem se reconfigurar.

“Quando analisamos áudio sintetizado”, explicou Balasubramaniyan, “às vezes encontramos detalhes que nos fazem perceber: ‘isso nunca poderia ter sido produzido por um humano, pois a pessoa que o fizesse precisaria de um pescoço de dois metros e meio de comprimento’”.

Existe também um grupo de sons denominados “fricativos”. Eles são produzidos quando o ar passa por uma restrição estreita na garganta, ao pronunciarmos letras como f, s, v e z. Os fricativos são especialmente difíceis para os sistemas de aprendizado profundo dominarem, pois o software tem dificuldade em distingui-los do ruído.

Então, pelo menos por enquanto, o software de clonagem de voz se depara com o fato de que os seres humanos são sacos de carne que fazem passar ar através de orifícios em seus corpos.