Quer construir seus próprios aplicativos generativos de IA? Aqui está uma lista de modelos de IA para ajudá-lo a começar.

Os modelos de IA são arquiteturas de redes neurais que funcionam extremamente bem em tarefas específicas. Isso inclui arquiteturas de redes neurais convolucionais para classificação e segmentação de imagens, modelos generativos pré-treinados de grandes linguagens, modelos de difusão para tarefas de geração de imagens e

Recentemente, os modelos de IA para aplicações generativas de IA – para imagem, fala, texto e muito mais – tornaram-se muito populares. Isso se deve tanto aos avanços na pesquisa quanto ao acesso à computação de alto desempenho.

Aqui está um rápido resumo dos modelos populares de IA que discutirei abaixo.

Capacidades ModelKeyGPT-4Um modelo de linguagem grande de código aberto pode ser usado para construir aplicativos baseados em LLMLLaMAVariedade de aplicativos de PNL, de chatbots a assistentes de codificaçãoFalcãoModelo de linguagem grande de código aberto pode ser usado para construir aplicativos baseados em LLMDifusão EstávelTexto para imagem, pintura interna de imagem, pintura externa e aumento de escalaDALL-E 2Geração de texto para imagemSussurrarReconhecimento de fala, tradução de idiomas e detecção de idiomaEstávelLMModelo de linguagem grande e leve de código abertoGRAMPOUma variedade de tarefas de PNL, como resposta a perguntas, resumo e geração de textoEstagiárioLMUm modelo de linguagem grande e de código aberto; pode ser usado para construir aplicativos baseados em LLMSegmentar qualquer modeloGeneralização zero-shot para uma variedade de tarefas de segmentação de imagensOndaGANGeração de áudioCicloGAN e pix2pixTradução de imagem para imagemBioGPTGeração e mineração de texto biomédico

Da arte de IA à construção de um assistente de codificação personalizado, você pode criar uma variedade de aplicativos generativos de IA com base em seus interesses. Aqui, listamos alguns modelos de IA interessantes que você pode explorar, juntamente com seus principais recursos.

Vamos começar!

últimas postagens

GPT-4

Desde a geração do itinerário para seus próximos planos de viagem até a elaboração de cartas de apresentação que se ajustem à descrição do cargo, o ChatGPT tornou-se parte de nossas tarefas diárias. GPT-4seu sucessor, é um modelo de linguagem grande ainda mais poderoso.

É o sistema de IA mais poderoso da OpenAI, com melhores capacidades de raciocínio e desempenho do que o ChatGPT.

Aqui está uma palestra técnica sobre como o GPT-4 funciona e como você pode criar aplicativos com ele.

Você pode acessar a interface ChatGPT com um conta OpenAI gratuita. Para acessar o GPT-4, entretanto, você deve ter uma assinatura do ChatGPT Plus.

Aqui estão alguns aplicativos que você pode construir com esses grandes modelos de linguagem:

- Chatbots personalizados

- Melhorando as plataformas de CRM

- Resposta a perguntas em um corpus personalizado

- Outras tarefas como resumo e geração de texto

A seguir, examinaremos alguns modelos de linguagem grande de código aberto.

LLaMA

Meta AI lançada LLaMA, um modelo básico de linguagem grande com parâmetros de 65B, em fevereiro de 2023. Posteriormente, o LLama 2 foi lançado com melhorias substanciais em relação à versão anterior. Você pode acessar o seguinte:

- Lhama Chat: Llama 2 aprimorado

- Código Llama: Construído no Llama 2; treinado em mais de 500 bilhões de tokens de código; suporta geração de código em todas as linguagens de programação mais populares

Você pode baixar e usar os modelos Llama clicando em solicitando acesso. Confira este tutorial para aprender como usar o LLama 2 em suas aplicações Python:

Falcão

Falcão é mais um modelo de linguagem de código aberto do Instituto de Inovação Tecnológica (Emirados Árabes Unidos). Todos os modelos do conjunto Falcon LLM são de código aberto e estão disponíveis para acesso aberto. Portanto, você pode usá-los para criar aplicativos com tecnologia LLM.

Atualmente, existem quatro tamanhos de modelo: 1,3B, 7,5B, 40B e 180B. para ter um desempenho melhor do que em vários benchmarks, o modelo 180B foi treinado em um conjunto de dados de tokens de 3,5T. O Falcon LLM tem desempenho equivalente a outros LLMs de código aberto líderes.

O LLM de código aberto Falcon 180B atinge desempenho próximo ao do GPT-4. Confira este tutorial que aborda o Falcon 180B, como você pode usá-lo, os requisitos de hardware e como comparar com o GPT-4:

Difusão Estável

Difusão Estável um modelo de texto para imagem para geração de imagens e outras aplicações criativas de IA. Também pode ser usado para aumento de escala e pintura interna de imagens.

Difusão Estável XLlançado em julho de 2023, oferece diversas melhorias, incluindo:

- gerando imagens descritivas a partir de prompts muito mais curtos

- a capacidade de gerar texto de suporte dentro de imagens

- tarefas de pintura interna e externa de imagens

- interagindo com uma imagem de origem para gerar variantes

Se você quiser aprender como funcionam os modelos de difusão – o método por trás da mágica – confira Como funcionam os modelos de difusãoum curso gratuito da DeepLearning.AI.

DALL-E 2

DALL-E 2 da Open AI é outro modelo popular de geração de texto para imagem. Você pode usá-lo para gerar imagens e arte realistas a partir de texto – descrição em linguagem natural.

Ele pode ser usado para as seguintes tarefas:

- geração de imagens a partir de prompts de texto

- pintura interna e externa de imagem

- gerando variações de uma imagem

Você pode acessar o DALL-E 2 através da API OpenAI ou do Interface web dos laboratórios OpenAI.

Sussurrar

IA aberta Sussurrar é um modelo de reconhecimento de fala que pode ser usado para uma infinidade de aplicações, incluindo:

- identificação de idioma

- tarefas de reconhecimento de fala, como transcrição de arquivos de áudio

- tradução de fala

Aqui está um tutorial sobre como converter fala em texto usando a API OpenAI Whisper:

Para testar o modelo, você pode instalar o Whisper (openai-whisper) usando pip e acessando a API de um script Python para transcrever arquivos de áudio. Além disso, você pode usar outros modelos de linguagem grandes para resumir a transcrição e construir um arquivo de áudio → pipeline de resumo.

EstávelLM

EstávelLM é um pacote LLM de código aberto da Stability AI. Os parâmetros 3B e 7B estão atualmente disponíveis. Os lançamentos subsequentes incluirão modelos maiores com parâmetros 15B – 65B.

Portanto, se quiser experimentar LLMs leves e de código aberto em seus aplicativos, você pode experimentar o StableLM.

GRAMPO

GRAMPO significa Pré-treinamento de linguagem-imagem contrastiva. É uma rede neural, um modelo multimodal, treinado em um grande conjunto de dados de pares (texto, imagem). O modelo aproveita dados de linguagem natural e tenta aprender – a partir das descrições em linguagem natural – a semântica das imagens. O modelo CLIP é capaz de prever o texto mais relevante de uma imagem.

Com o CLIP, você pode realizar classificação de imagens de disparo zero, sem pré-treinamento e ajuste fino caros. Além disso, você pode aproveitar os recursos do CLIP e dos bancos de dados vetoriais para criar aplicativos interessantes em:

- pesquisa de texto para imagem e imagem para imagem

- pesquisa reversa de imagens

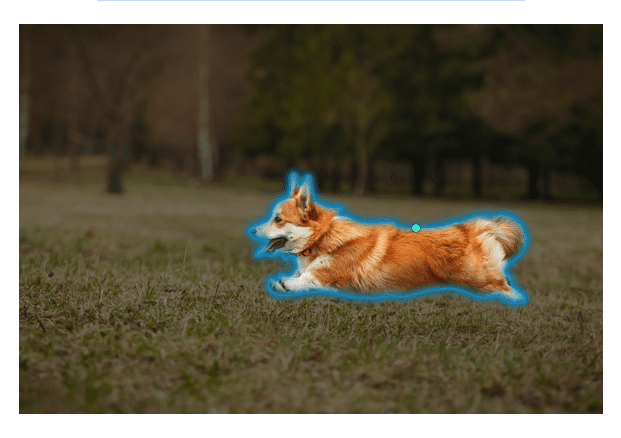

Segmentar qualquer modelo

A segmentação de imagens é a tarefa de identificar pixels pertencentes a um objeto específico dentro de uma imagem. Meta AI lançada Segmentar qualquer modelo (SAM) que pode ser usado para segmentar qualquer imagem e recortar objetos dela.

Fonte da imagem: Segmentar qualquer coisa

Fonte da imagem: Segmentar qualquer coisa

Você pode usar prompts para especificar o que segmentar em uma imagem. Atualmente, o SAM suporta os seguintes prompts: caixas delimitadoras, máscaras e pontos de primeiro e segundo plano. O modelo também possui excelente desempenho de generalização de disparo zero em imagens nunca antes vistas. Portanto, nenhum treinamento explícito é necessário.

Experimente o Modelo SAM no seu navegador!

EstagiárioLM

EstagiárioLM é um modelo de linguagem de código aberto. Você pode experimentar o modelo básico 7B e o modelo de chat de código aberto. O modelo suporta uma janela de contexto de 8K. Além disso, o InternLM oferece suporte a intérpretes de código e recursos de chamada de função.

InternLM também está disponível na biblioteca de transformadores HuggingFace. Você pode aproveitar a estrutura leve de pré-treinamento. Ele também oferece suporte à construção e implantação de aplicativos usando LMDeploy. Assim, você pode construir aplicativos de PNL generativos de ponta a ponta com InternLM.

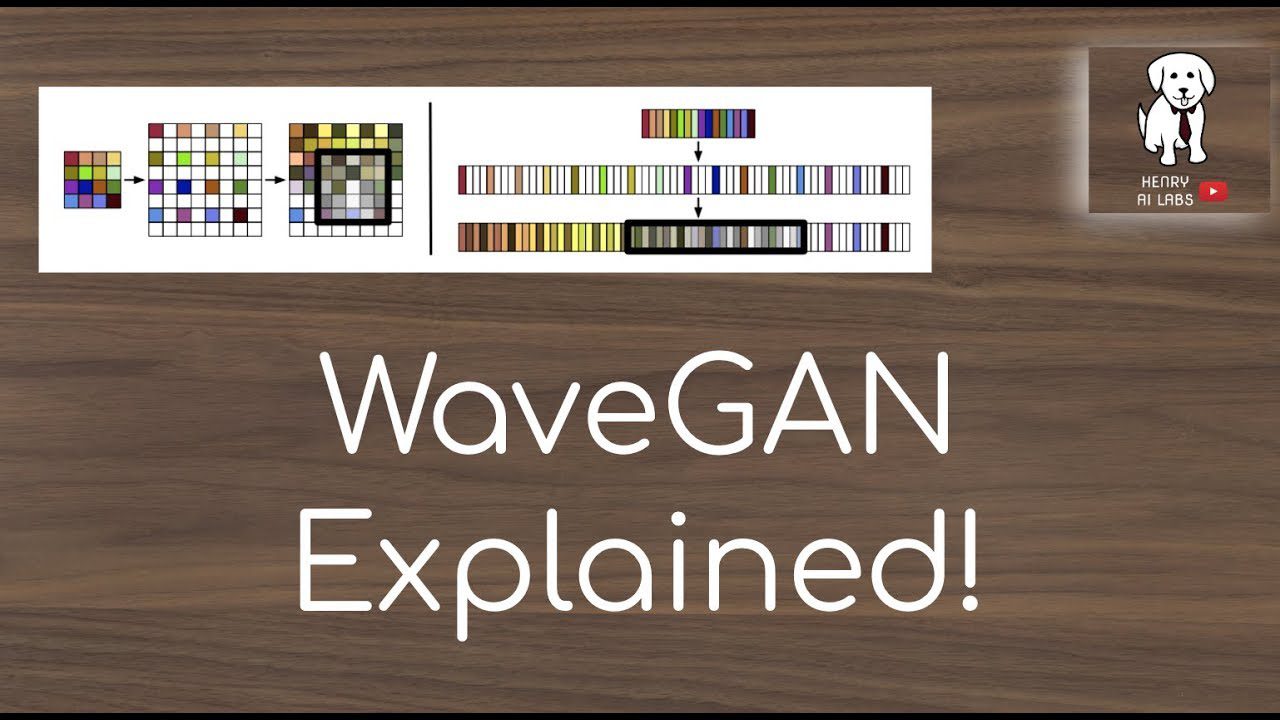

OndaGAN

OndaGAN é um modelo para geração de áudio. Ajuda a sintetizar áudio bruto a partir de amostras de dados de áudio reais.

Você pode treinar o WaveGAN em um conjunto de dados de arquivos de áudio arbitrários e sintetizar áudio sem pré-processamento extenso.

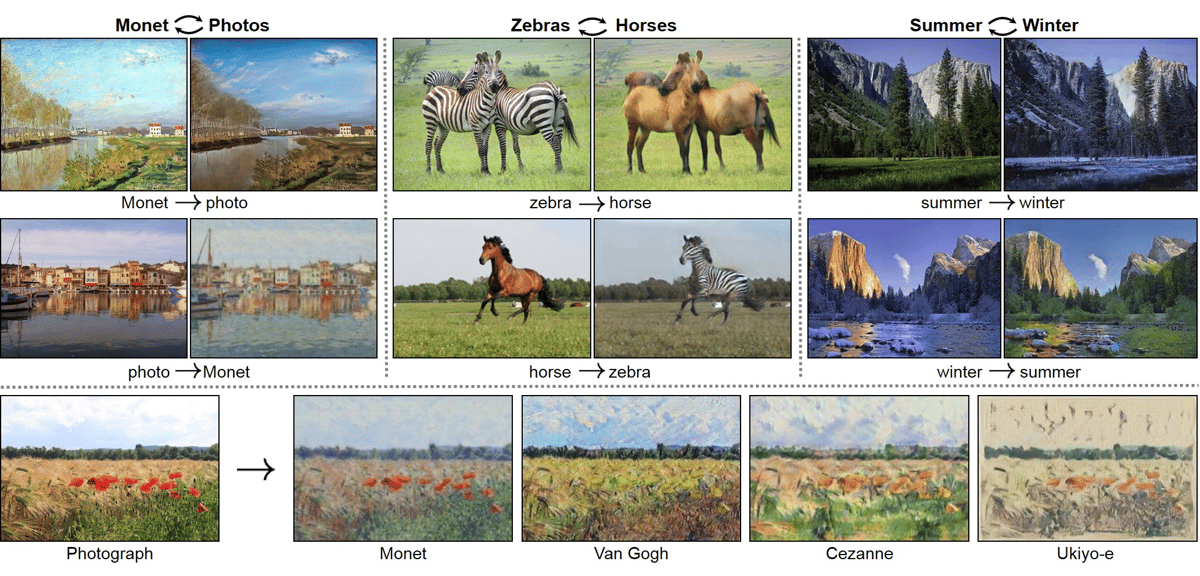

CicloGAN e Pix2Pix

Até agora, cobrimos fala para texto, texto para imagem e outros modelos para diversas tarefas de processamento de linguagem natural. Mas e se você quiser realizar uma tradução imagem para imagem? Aqui você pode usar CicloGAN para aprender um mapeamento do domínio de origem para o domínio de destino para realizar a tradução de imagem para imagem.

Por exemplo, dada a imagem de um lago durante o inverno, você pode querer traduzir a mesma imagem quando a estação for verão. Na imagem de um cavalo, você pode substituir o cavalo por uma zebra, mantendo o mesmo fundo. CycleGAN é adequado para tais tarefas.

O modelo pix2pix pode ser usado para tradução de imagem para imagem; os principais recursos do modelo incluem:

- reconstruindo objetos a partir de mapas de bordas e

- colorir imagens

Você pode encontrar as implementações PyTorch de CycleGAN e pix2pix no GitHub.

BioGPT

BioGPT da Microsoft é um modelo de transformador que você pode usar para mineração de dados biomédicos e aplicativos de geração de texto. Ele usa as implementações do modelo sequência a sequência fornecidas por fairseq.

Fairseq da pesquisa do Facebook (agora Meta AI) é um kit de ferramentas que fornece implementações de modelos sequência a sequência para tarefas como:

- modelagem de linguagem

- tradução

- resumo

Tanto o modelos pré-treinados e pontos de verificação de modelo ajustados estão disponíveis. Você pode baixar o modelo do URL ou do hub HuggingFace.

Os modelos BioGPT também fazem parte da biblioteca de transformadores HuggingFace. Portanto, se você trabalha na área biomédica, pode usar o BioGPT para construir aplicativos específicos de domínio.

Empacotando

Espero que você tenha encontrado alguns modelos úteis com os quais possa construir aplicativos generativos de IA. Embora esta lista não seja exaustiva, cobrimos alguns dos modelos mais populares que você pode usar para criar aplicativos para geração de texto e áudio, transcrição de fala para texto, pesquisa de imagens e muito mais.

Ao criar aplicativos usando grandes modelos de linguagem, você deve estar ciente das armadilhas comuns, como informações factualmente incorretas e alucinações. E você pode enfrentar limitações ao ajustar modelos, pois o processo de ajuste geralmente consome muitos recursos.

Então, se você é um desenvolvedor, é hora de se juntar à revolução da IA e começar a construir aplicações de IA interessantes! Você pode experimentar esses modelos no Google Colab ou em outros notebooks colaborativos de ciência de dados.