Está à procura de soluções para otimizar o seu posicionamento, visibilidade e taxas de conversão em SEO? Uma ferramenta de rastreamento web é essencial. Um rastreador web, também conhecido como “spider” ou “bot”, é um programa informático que explora a internet, analisando páginas e recolhendo dados. Exemplos incluem software de extração de dados e programas de “scraping” de websites. Hoje, vamos apresentar algumas ferramentas de rastreamento web gratuitas para download.

As 25 Melhores Ferramentas Gratuitas de Rastreamento Web

As ferramentas de rastreamento web são poderosas aliadas na mineração e análise de dados. O seu objetivo principal é indexar páginas da web. Estas ferramentas são capazes de detetar links quebrados, conteúdo duplicado, ausência de títulos de página e identificar problemas de SEO críticos. A extração de dados online pode trazer inúmeros benefícios para a sua empresa.

- Várias aplicações de rastreamento web podem extrair dados de forma precisa a partir de qualquer URL.

- Estes programas auxiliam na otimização da estrutura do seu site, facilitando a compreensão pelos motores de busca e melhorando o seu posicionamento.

Na nossa lista das melhores ferramentas, compilamos uma seleção de ferramentas de rastreamento web gratuitas para download, com informações sobre os seus recursos e custos, incluindo também opções pagas.

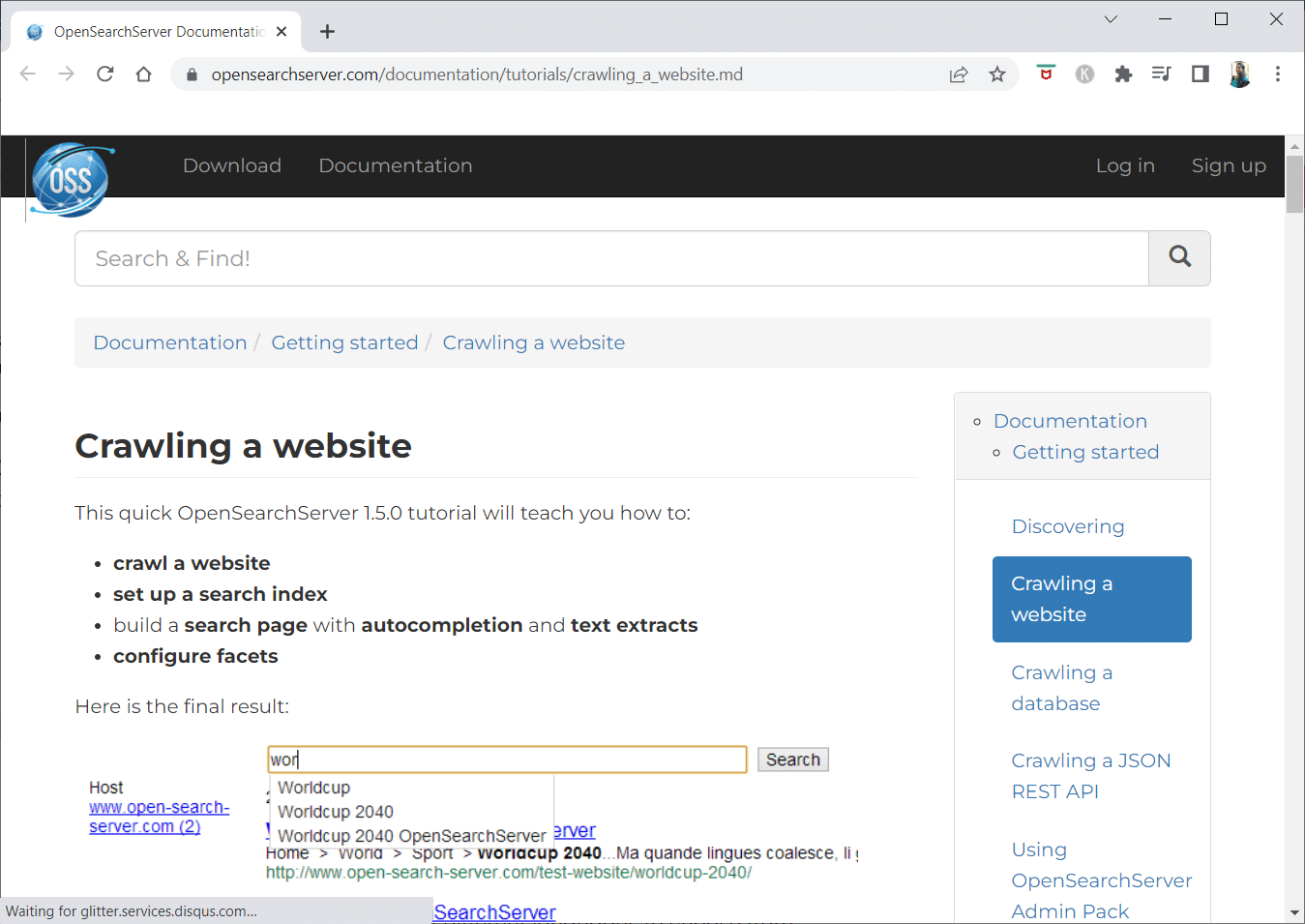

1. OpenSearchServer

O OpenSearchServer é um rastreador web gratuito, altamente cotado na internet. É uma das melhores alternativas disponíveis.

- É uma solução completamente integrada.

- O OpenSearchServer é um motor de rastreamento e pesquisa web gratuito e de código aberto.

- Apresenta uma solução completa e acessível.

- Inclui um conjunto abrangente de funcionalidades de pesquisa e a capacidade de construir a sua própria estratégia de indexação.

- Os rastreadores podem indexar praticamente qualquer tipo de conteúdo.

- Oferece pesquisas de texto completo, booleanas e fonéticas.

- Disponível em 17 idiomas diferentes.

- Realiza classificações automáticas.

- Permite agendar tarefas recorrentes.

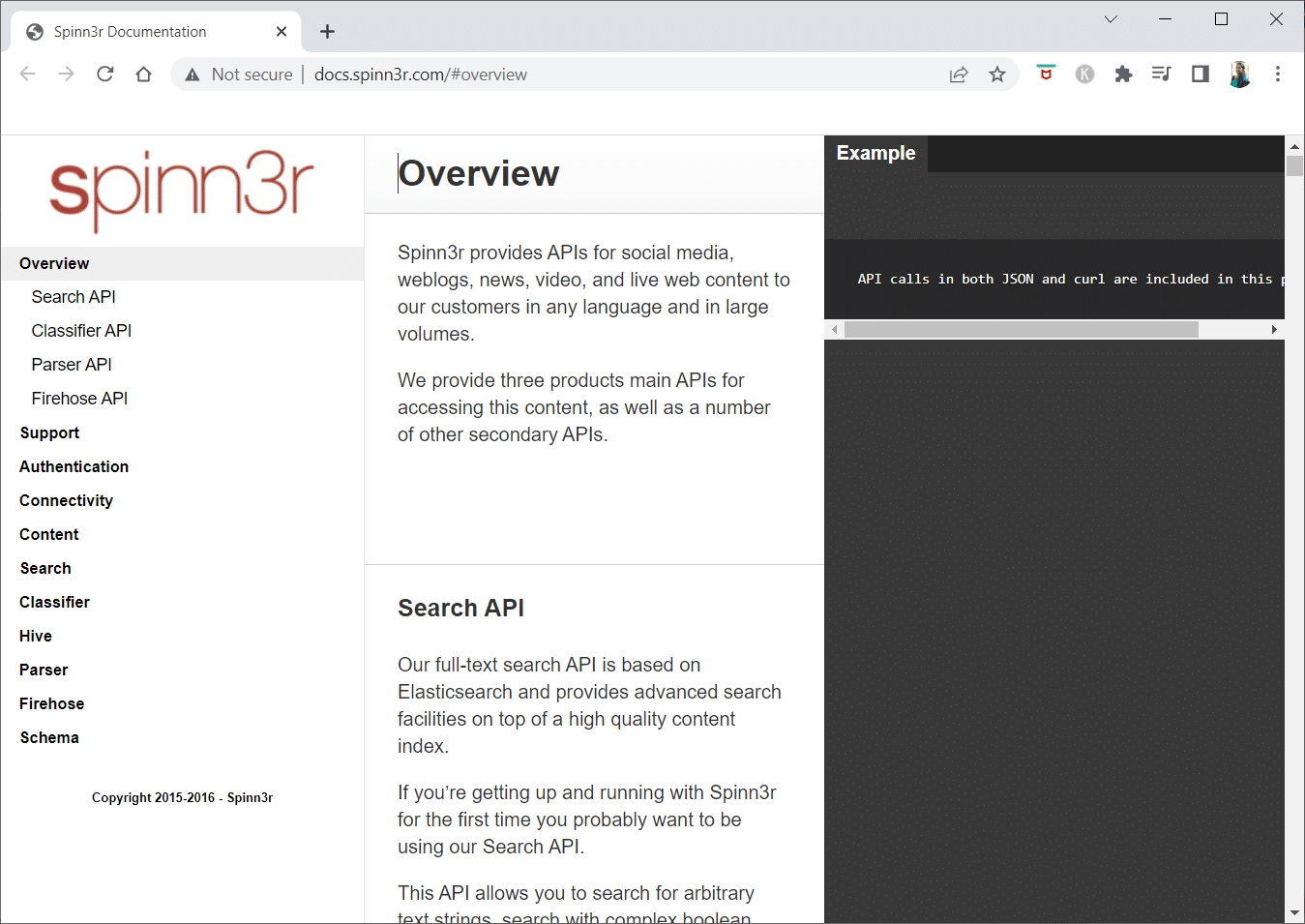

2. Spinn3r

O Spinn3r é um rastreador web capaz de extrair conteúdo de blogs, notícias, redes sociais, feeds RSS e ATOM.

- Possui uma API de alta velocidade que automatiza 95% do trabalho de indexação.

- Inclui proteção avançada contra spam, removendo conteúdo impróprio e melhorando a segurança dos dados.

- O “web scraper” monitoriza continuamente a web para apresentar conteúdo atualizado em tempo real.

- Indexa o conteúdo de forma semelhante ao Google e os dados são guardados em formato JSON.

- A API do Parser permite analisar e gerir rapidamente informações de URLs web arbitrários.

- A API Firehose foi concebida para acesso massivo a grandes volumes de dados.

- Utiliza cabeçalhos HTTP para autenticar todas as APIs do Spinn3r.

- Esta ferramenta de rastreamento web é gratuita para download.

- A API do classificador permite que desenvolvedores enviem texto (ou URLs) para serem categorizados por tecnologia de aprendizado de máquina.

3. Import.io

O Import.io permite extrair milhões de páginas web em minutos e criar mais de 1000 APIs personalizadas, sem a necessidade de escrever código.

- Pode ser operado programaticamente, com recuperação automática de dados.

- Extraia dados de múltiplas páginas com um simples clique.

- Deteta automaticamente listas paginadas ou permite selecionar a próxima página manualmente.

- Incorpore dados online na sua aplicação ou site com poucos cliques.

- Crie URLs com base em padrões como números de página e nomes de categorias.

- O Import.io facilita a demonstração da extração de dados; basta selecionar uma coluna e indicar o elemento desejado na página.

- Pode obter uma cotação no site.

- Os links nas páginas de lista levam a páginas detalhadas com informações adicionais.

- O Import.io permite agregar dados de páginas de detalhes de uma só vez.

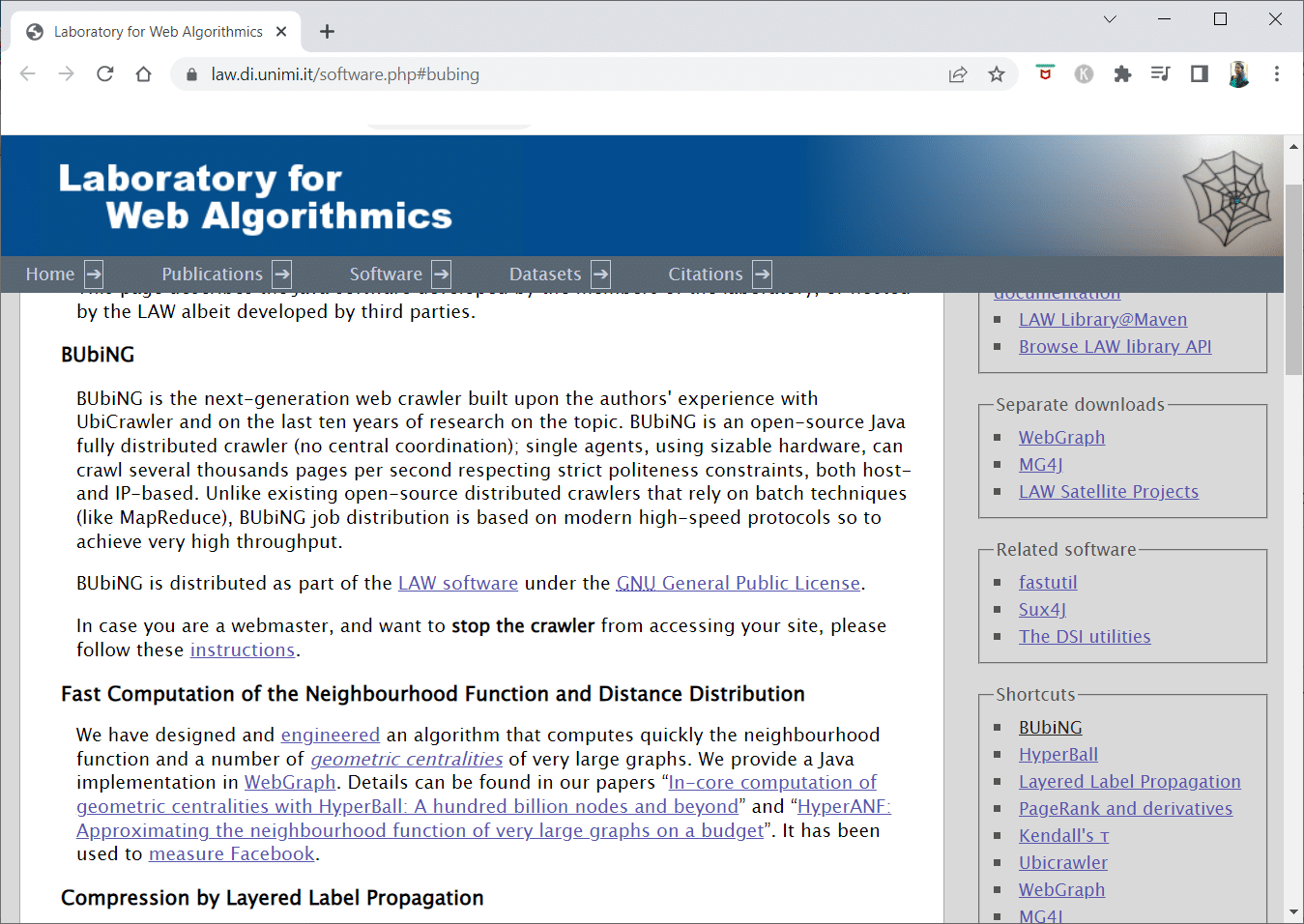

4. BUbiNG

BUbiNG é uma ferramenta de rastreamento web avançada, resultado da experiência dos autores com o UbiCrawler e de uma década de pesquisa na área.

- Pode rastrear milhares de páginas por segundo, respeitando os padrões de cortesia, tanto por host como por IP.

- A distribuição do trabalho baseia-se em protocolos contemporâneos de alta velocidade, proporcionando elevado rendimento, ao contrário de rastreadores distribuídos de código aberto que utilizam técnicas em lote.

- Deteta quase-duplicados através da impressão digital de uma página eliminada.

- BUbiNG é um rastreador Java de código aberto completamente distribuído.

- Oferece elevado paralelismo.

- É amplamente utilizado.

- É rápido.

- Permite o rastreamento em larga escala.

5. GNU Wget

O GNU Wget é uma ferramenta gratuita de rastreamento web, disponível para download, sendo um programa de código aberto escrito em C para obter arquivos através de HTTP, HTTPS, FTP e FTPS.

- A sua capacidade de criar arquivos de mensagens baseados em NLS em vários idiomas é um dos aspetos mais distintivos.

- Permite retomar downloads interrompidos usando REST e RANGE.

- Converte links absolutos em links relativos, se necessário.

- Utiliza “wildcards” para nomes de arquivos e espelha diretórios recursivamente.

- Disponibiliza arquivos de mensagens baseados em NLS para vários idiomas.

- Avalia os carimbos de data/hora para determinar se os documentos precisam ser descarregados novamente durante o espelhamento.

6. Webhose.io

O Webhose.io é um aplicativo de rastreamento web que permite analisar dados e extrair palavras-chave em vários idiomas, utilizando diversos filtros abrangendo várias fontes.

- Permite visualizar dados anteriores.

- Os dados de rastreamento estão disponíveis em até 80 idiomas.

- Permite localizar informações pessoais comprometidas.

- Investiga “darknets” e aplicações de mensagens para identificar ameaças cibernéticas.

- Os dados extraídos estão acessíveis nos formatos XML, JSON e RSS.

- Permite obter uma cotação no site.

- Indexa e pesquisa dados estruturados.

- Monitoriza e analisa meios de comunicação em todos os idiomas.

- Rastreia discussões em fóruns e plataformas.

- Acompanha as principais publicações de blogs em toda a web.

7. Norconex

Norconex é uma excelente opção para empresas que procuram um aplicativo de rastreamento web de código aberto.

- Pode ser utilizado ou integrado ao seu programa.

- Extrai a imagem em destaque de uma página.

- Permite rastrear o conteúdo de qualquer site.

- É compatível com qualquer sistema operacional.

- Pode rastrear milhões de páginas num único servidor de capacidade média.

- Inclui ferramentas para modificação de conteúdo e metadados.

- Extrai metadados de documentos.

- Suporta páginas renderizadas por JavaScript.

- Deteta vários idiomas.

- Oferece assistência de tradução.

- Permite ajustar a velocidade de rastreamento.

- Identifica documentos modificados ou removidos.

- É uma ferramenta de rastreamento web totalmente gratuita.

8. Dexi.io

Dexi.io é um aplicativo de rastreamento web baseado em navegador que permite obter informações de qualquer site.

- Disponibiliza três tipos de robôs para extração: extratores, rastreadores e tubos.

- Prevê tendências de mercado através de relatórios do Delta.

- Os dados coletados são preservados por duas semanas nos servidores Dexi.io ou podem ser exportados como arquivos JSON ou CSV.

- Permite obter uma cotação no site.

- Oferece serviços profissionais como garantia de qualidade e manutenção contínua.

- Disponibiliza serviços comerciais para atender às necessidades de dados em tempo real.

- Rastreia inventário e preços de um número ilimitado de SKUs/produtos.

- Integra dados usando painéis ao vivo e análises completas de produtos.

- Auxilia na preparação e organização de dados de produtos, prontos para uso na web.

9. Zyte

Zyte é uma ferramenta de extração de dados baseada em nuvem que auxilia milhares de desenvolvedores a encontrar informações cruciais. É também uma das melhores aplicações de rastreamento web gratuitas.

- Permite raspar páginas web através de um aplicativo visual de código aberto, sem necessidade de codificação.

- O Crawlera, um rotador de proxy complexo da Zyte, permite rastrear sites grandes ou protegidos por bots, evitando contramedidas.

- Garante a entrega de informações online de forma consistente.

- Permite gerir antibots direcionados à camada do navegador através de recursos e renderização inteligente.

- Permite obter uma cotação no site.

- Rastreia múltiplos IPs e regiões usando uma API HTTP simples, eliminando a necessidade de manutenção de proxy.

- Ajuda a gerar valor e economizar tempo ao obter as informações necessárias.

- Permite extrair dados web em grande escala, poupando tempo em codificação e manutenção.

10. Apache Nutch

O Apache Nutch é uma das principais ferramentas de rastreamento web de código aberto.

- Pode operar numa única máquina, mas tem melhor desempenho num cluster Hadoop.

- Utiliza o protocolo NTLM para autenticação.

- Possui um sistema de arquivos distribuído (via Hadoop).

- É um projeto de código aberto conhecido, adaptável e escalável para mineração de dados.

- É utilizado por analistas de dados, cientistas, desenvolvedores de aplicações e especialistas em mineração de texto da web em todo o mundo.

- É uma solução multiplataforma baseada em Java.

- A busca e a análise são realizadas de forma independente.

- Os dados são mapeados usando XPath e “namespaces”.

- Inclui uma base de dados de gráficos de links.

11. VisualScraper

O VisualScraper é outro “web scraper” que não requer codificação para extrair dados da internet.

- Oferece uma interface de utilizador simples, com função de apontar e clicar.

- Oferece serviços de “scraping” online, disseminação de dados e construção de extratores de software.

- Monitoriza os concorrentes.

- Permite agendar projetos para serem executados num determinado horário ou repetir a sequência a cada minuto, dia, semana, mês e ano.

- É acessível e eficaz.

- Não requer qualquer código.

- É um programa de rastreamento web totalmente gratuito.

- Permite extrair dados em tempo real de múltiplas páginas web e guardá-los em arquivos CSV, XML, JSON ou SQL.

- Extrai notícias, atualizações e publicações de fóruns regularmente.

- Os dados são precisos e personalizados.

12. WebSphinx

O WebSphinx é um aplicativo de rastreamento web pessoal e gratuito, fácil de configurar e usar.

- É destinado a utilizadores avançados e programadores Java que desejam rastrear uma parte limitada da internet automaticamente.

- Inclui uma biblioteca de classes Java e um ambiente de programação interativo.

- Permite concatenar páginas num único documento para leitura ou impressão.

- Extrai texto que se enquadra num determinado padrão numa sequência de páginas.

- Permite escrever rastreadores web em Java.

- Inclui o “Crawler Workbench” e a biblioteca de classes WebSPHINX.

- O “Crawler Workbench” é uma interface gráfica que permite personalizar e operar um rastreador web.

- Permite criar um gráfico a partir de um grupo de páginas web.

- Guarda páginas localmente para leitura offline.

13. OutWit Hub

O OutWit Hub consiste num “kernel” com uma biblioteca de recursos de reconhecimento e extração de dados, onde vários aplicativos podem ser criados, utilizando os recursos do “kernel”.

- Rastreia sites e preserva os dados de forma acessível.

- É um coletor multiuso com recursos para acomodar vários requisitos.

- Existe há muito tempo.

- É uma plataforma útil para utilizadores não técnicos e profissionais de TI que sabem codificar, mas reconhecem que o PHP nem sempre é ideal para extrair dados.

- O OutWit Hub oferece uma interface única para extrair dados, de acordo com as necessidades.

- Extrai dados diretamente do navegador e constrói agentes automatizados que capturam dados e os preparam de acordo com os requisitos.

- Permite obter uma cotação no site.

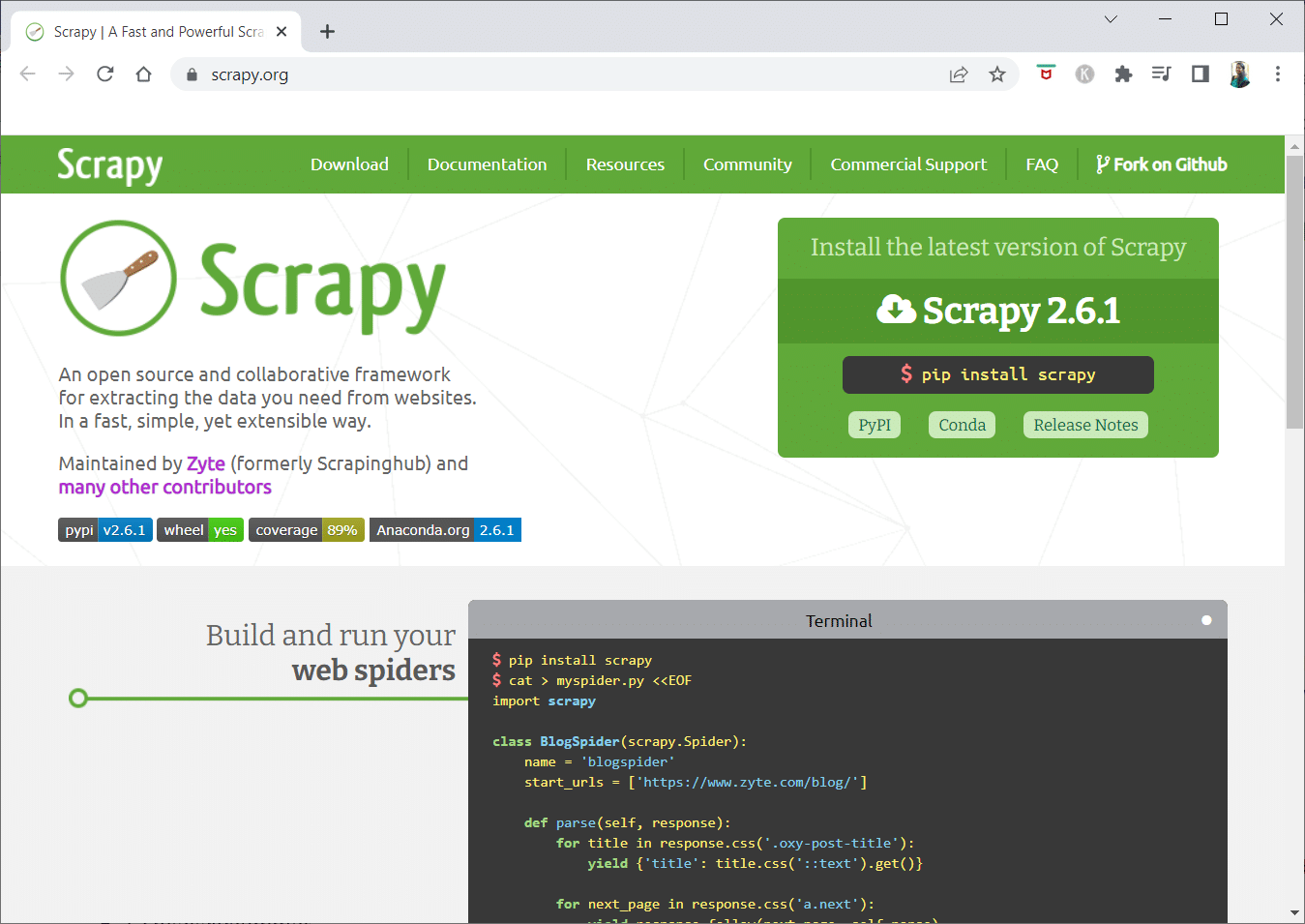

14. Scrapy

Scrapy é uma estrutura de “scraping” online do Python para criar rastreadores web escaláveis.

- Lida com as características que dificultam a criação de rastreadores, como “middleware” de proxy e perguntas de consulta.

- Permite escrever regras para extrair dados, deixando o resto ao Scrapy.

- Facilita a adição de novos recursos sem modificar o núcleo, devido à sua arquitetura modular.

- É um programa baseado em Python, compatível com Linux, Windows, Mac OS X e BSD.

- É uma ferramenta totalmente gratuita.

- A sua biblioteca fornece aos programadores uma estrutura para personalizar rastreadores web e extrair dados em grande escala.

15. Mozenda

Mozenda é uma aplicação de rastreamento web gratuita, um programa de “web scraping” de autoatendimento baseado em nuvem, orientado para negócios, com mais de 7 bilhões de páginas rastreadas e clientes corporativos em todo o mundo.

- A sua tecnologia de “web scraping” elimina a necessidade de scripts e de contratar engenheiros.

- Acelera a coleta de dados em cinco vezes.

- Permite extrair texto, arquivos, imagens e informações em PDF de sites através de função de apontar e clicar.

- Permite organizar arquivos de dados para publicação.

- Pode exportar diretamente para TSV, CSV, XML, XLSX ou JSON usando a API do Mozenda.

- Permite organizar informações para tomar decisões cruciais através da função Data Wrangling.

- Integra dados com as plataformas parceiras da Mozenda ou estabelecer integrações personalizadas.

16. Cyotek Webcopy

Cyotek Webcopy é uma ferramenta gratuita de rastreamento web que permite descarregar automaticamente o conteúdo de um site para o seu dispositivo local.

- Analisa e descarrega o conteúdo do site escolhido.

- Permite selecionar as partes do site a clonar e definir a sua estrutura complexa.

- Redireciona links para recursos do site (folhas de estilo, imagens, páginas) para a rota local.

- Analisa a marcação HTML do site e tenta encontrar recursos ligados (sites, fotos, vídeos, downloads de arquivos).

- Rastreia um site e descarrega o conteúdo para criar uma cópia aceitável do original.

17. Common Crawl

O Common Crawl foi concebido para quem tem interesse em explorar e analisar dados para obter informações úteis.

- É uma organização sem fins lucrativos 501(c)(3) que depende de doações para operar.

- É acessível a quem deseja utilizar o Common Crawl, sem custos ou problemas.

- É um “corpus” para ensino, pesquisa e análise.

- Artigos sobre descobertas notáveis feitas com dados do Common Crawl estão disponíveis para quem não possui habilidades técnicas.

- Os professores podem usar estas ferramentas para ensinar análise de dados.

18. Semrush

Semrush é um aplicativo de rastreamento de sites que examina as páginas e a estrutura do seu site para identificar problemas técnicos de SEO. A correção desses problemas pode melhorar os resultados da pesquisa.

- Inclui ferramentas para SEO, pesquisa de mercado, marketing de mídia social e publicidade.

- Possui uma interface de utilizador amigável.

- Analisa metadados, HTTP/HTTPS, diretivas, códigos de “status”, conteúdo duplicado, velocidade de resposta da página, links internos, tamanhos de imagem, dados estruturados, entre outros.

- Permite auditar um site de forma rápida e simples.

- Auxilia na análise de arquivos de log.

- Disponibiliza um painel para visualizar facilmente os problemas do site.

19. Sitechecker.pro

O Sitechecker.pro é outra aplicação de rastreamento web gratuita. É um verificador de SEO para sites que ajuda a melhorar o posicionamento.

- Visualiza facilmente a estrutura de uma página web.

- Cria relatórios de auditoria de SEO na página, que podem ser enviados por e-mail.

- Analisa os links internos e externos do seu site.

- Ajuda a determinar a velocidade do site.

- Verifica problemas de indexação nas páginas de destino.

- Ajuda a defender-se contra ataques de “hackers”.

20. Webharvy

Webharvy é uma ferramenta de “scraping” web com interface simples de apontar e clicar, para quem não sabe codificar.

- O custo da licença começa em $139.

- Utiliza o navegador integrado do WebHarvy para carregar sites online e selecionar os dados a extrair com cliques do “mouse”.

- Extrai automaticamente texto, fotos, URLs e e-mails e guarda em vários formatos.

- Permite utilizar servidores proxy ou VPN para aceder a sites de destino.

- Não requer a criação de programas ou aplicações para a extração de dados.

- Permite navegar anonimamente e impedir o bloqueio por servidores web usando proxies ou VPNs.

- Identifica automaticamente padrões de dados em sites.

- Extrai listas de objetos de uma página web sem necessidade de configurações adicionais.

21. NetSpeak Spider

O NetSpeak Spider é um aplicativo de rastreamento web para desktop para auditorias diárias de SEO, identificação rápida de problemas e análise sistemática de páginas web.

- Avalia grandes páginas web, minimizando o uso de RAM.

- Permite importar e exportar dados de rastreamento web em arquivos CSV.

- Identifica problemas de SEO de sites com poucos cliques.

- Avalia a otimização “on-page” de um site, incluindo código de “status”, instruções de rastreamento e indexação, estrutura do site e redirecionamentos.

- Permite exportar dados do Google Analytics e Yandex.

- Considera o intervalo de dados, o tipo de dispositivo, a segmentação de páginas, tráfego, conversões e configurações de comércio eletrónico.

- As assinaturas mensais começam em $21.

- Deteta links e fotos quebrados, material duplicado (páginas, textos, “tags” de título e meta descrição, H1s).

22. UiPath

UiPath é uma ferramenta de “scraping” online que permite automatizar procedimentos robóticos, incluindo o rastreamento de dados online e “desktop” para a maioria dos programas de terceiros.

- Pode ser instalado em Windows.

- Extrai dados em formulários tabulares e baseados em padrões de múltiplas páginas web.

- Permite realizar rastreamentos adicionais imediatamente.

- Os relatórios acompanham os robôs, permitindo consultar a documentação a qualquer momento.

- Padronizar as práticas melhora a eficiência dos resultados.

- As assinaturas mensais começam em $420.

- Mais de 200 componentes prontos no “Marketplace” otimizam o tempo da equipa.

- Os robôs UiPath aumentam a conformidade, seguindo o método exato que atende às necessidades.

- Permite alcançar uma transformação digital rápida, otimizando processos, reconhecendo economias e oferecendo insights.

23. Helium Scraper

O Helium Scraper é um aplicativo visual de rastreamento de dados online que funciona melhor quando há pouca associação entre os elementos. Atende aos requisitos básicos de rastreamento.

- Não requer codificação ou configuração.

- Permite selecionar e adicionar atividades a partir de uma lista.

- Modelos online estão disponíveis para requisitos de rastreamento específicos.

- Utiliza vários navegadores web Chromium.

- Permite aumentar o número de navegadores para obter o máximo de dados possível.

- Permite definir ações personalizadas ou utilizar JavaScript para instâncias mais complexas.

- Pode ser instalado em computadores pessoais ou em servidores Windows dedicados.

- As licenças começam em $99.

24. 80 Legs

A 80Legs foi fundada em 2009 para tornar os dados online mais acessíveis, sendo uma das melhores ferramentas de rastreamento web gratuitas. Inicialmente, a empresa concentrou-se em fornecer serviços de rastreamento web a vários clientes.

- Fornece informações personalizadas através de um aplicativo de rastreamento web abrangente.

- A velocidade de rastreamento é ajustada automaticamente com base no tráfego do site.

- Permite descarregar os resultados no seu computador ou ambiente local.

- Basta fornecer um URL para rastrear o site.

- As assinaturas mensais começam em $29.

- Permite construir e executar rastreamentos web via SaaS.

- Possui vários servidores para visualizar o site a partir de vários endereços IP.

- Garante acesso imediato aos dados do site, em vez de vasculhar a web.

- Facilita a criação e execução de rastreamentos web personalizados.

- Permite acompanhar tendências online.

- Permite criar modelos personalizados.

25. ParseHub

ParseHub é um aplicativo de rastreamento web que pode coletar informações de sites que usam AJAX, JavaScript, “cookies” e outras tecnologias relacionadas.

- O seu motor de aprendizado de máquina pode ler, avaliar e converter conteúdo online em dados significativos.

- Pode usar o aplicativo web integrado no navegador.

- Extrai informações de milhões de sites.

- Pesquisa automaticamente milhares de links e palavras.

- Os dados são coletados e armazenados automaticamente nos seus servidores.

- Os pacotes mensais começam em $149.

- A versão “shareware” permite construir cinco projetos públicos.

- Acessa menus suspensos, faz login em sites, clica em mapas e gere páginas web com rolagem infinita, “tabs” e “pop-ups”.

- O cliente para desktop está disponível para Windows, Mac OS X e Linux.

- Permite obter os dados raspados em qualquer formato para análise.

- Permite estabelecer pelo menos 20 projetos privados de “scraping” com níveis de associação “premium”.

***

Esperamos que este artigo tenha sido útil e que tenha escolhido a sua ferramenta de rastreamento web favorita. Partilhe as suas opiniões, dúvidas e sugestões na secção de comentários abaixo. Além disso, pode sugerir as ferramentas que faltam. Informe-nos sobre o que gostaria de aprender a seguir.