O enviesamento algorítmico pode ter um impacto significativo em diversas áreas das nossas vidas, desde as recomendações de conteúdo online até à procura de emprego e decisões financeiras.

É inerente à condição humana a existência de preconceitos. Cada pessoa é única, com diferentes géneros, etnias, níveis de educação, formações, culturas, crenças e experiências.

As nossas opiniões, pensamentos, gostos, aversões e preferências variam consideravelmente entre indivíduos. Esta diversidade pode levar ao desenvolvimento de preconceitos favoráveis ou desfavoráveis em relação a categorias específicas.

As máquinas não são exceção. Elas podem interpretar pessoas, objetos e acontecimentos de maneiras distintas, devido a preconceitos introduzidos nos seus algoritmos. Estes preconceitos podem resultar em sistemas de IA e ML que produzem resultados injustos, prejudicando pessoas de diversas formas.

Neste artigo, vamos analisar o conceito de enviesamento algorítmico, os seus diferentes tipos e as estratégias para detetar e mitigar este problema, promovendo assim resultados mais equitativos.

Vamos começar!

O que são Vieses Algorítmicos?

Um viés algorítmico é a tendência de algoritmos de IA e ML refletirem preconceitos semelhantes aos dos humanos, gerando resultados que não são justos. Estes preconceitos podem ter origem no género, idade, etnia, religião, cultura, entre outros fatores.

No âmbito da inteligência artificial e aprendizagem automática, os enviesamentos algorítmicos são erros sistemáticos e repetitivos introduzidos num sistema que levam a resultados injustos.

Os vieses nos algoritmos podem surgir por várias razões, tais como as decisões tomadas durante a recolha e seleção de dados, a forma como os dados são codificados ou usados no treino do algoritmo, o uso pretendido, o design do algoritmo, etc.

Por exemplo, pode observar enviesamentos algorítmicos nos resultados de motores de busca, resultando em violações de privacidade e preconceitos sociais, entre outros.

Existem inúmeros casos de enviesamentos algorítmicos em áreas como os resultados eleitorais, a disseminação de discursos de ódio online, saúde, justiça criminal e recrutamento. Estes enviesamentos estão a agravar os preconceitos já existentes no que diz respeito a género, etnia, economia e sociedade.

Tipos de Enviesamentos Algorítmicos

#1. Viés de Dados

Ocorre quando os dados usados para treinar um modelo de IA não representam adequadamente as populações ou cenários reais. Isto pode resultar em conjuntos de dados desequilibrados ou distorcidos.

Fonte: TELUS Internacional

Fonte: TELUS Internacional

Um exemplo: Imagine um software de reconhecimento facial que é treinado principalmente com dados de indivíduos de pele clara. Este software poderá ter um desempenho inferior ao tentar reconhecer pessoas com tons de pele mais escuros, afetando-as negativamente.

#2. Viés de Medição

Este viés pode surgir devido a erros no processo de medição ou recolha de dados.

Por exemplo: Se um algoritmo de diagnóstico médico for treinado para identificar uma doença com base em dados como consultas médicas anteriores, isso poderá distorcer a avaliação, causando preconceitos e ignorando sintomas reais.

#3. Viés de Modelo

Os vieses de modelo ocorrem durante a conceção do algoritmo ou modelo de IA.

Por exemplo: Um sistema de IA que tenha um algoritmo projetado para maximizar os lucros a qualquer custo pode acabar por priorizar ganhos financeiros em detrimento de considerações éticas, segurança e justiça.

#4. Viés de Avaliação

Ocorre quando os critérios ou fatores utilizados para avaliar o desempenho de um sistema de IA são enviesados.

Fonte: Limpar revisão

Fonte: Limpar revisão

Por exemplo: Se um sistema de IA para avaliação de desempenho usar testes padronizados que favorecem uma categoria específica de funcionários, isso pode levar a desigualdades.

#5. Viés de Relato

Ocorre quando o conjunto de dados de treino não reflete com precisão a frequência real dos eventos.

Por exemplo: Se uma ferramenta de segurança de IA tiver um mau desempenho numa determinada categoria, poderá sinalizar essa categoria como suspeita na sua totalidade.

Isto significa que o conjunto de dados com o qual o sistema foi treinado marcou todos os incidentes históricos relacionados com essa categoria como inseguros, devido à maior frequência de incidentes.

#6. Viés de Seleção

Este viés surge quando os dados de treino são selecionados sem a devida aleatoriedade ou não representam a população total de forma adequada.

Por exemplo: Se uma ferramenta de reconhecimento facial for treinada com base em dados limitados, poderá começar a discriminar dados menos comuns, como a identificação de mulheres negras em cargos políticos em comparação com homens e indivíduos de pele clara na política.

#7. Viés Implícito

Surge quando o algoritmo de IA faz suposições com base em experiências pessoais que podem não se aplicar a categorias ou grupos mais abrangentes.

Por exemplo: Se um cientista de dados, ao desenvolver um algoritmo de IA, acreditar que as mulheres preferem predominantemente o rosa em detrimento do azul ou do preto, o sistema poderá recomendar produtos com base nesse preconceito, o que não se aplica a todas as mulheres. Muitas preferem o azul ou o preto.

#8. Viés de Atribuição de Grupo

Este viés ocorre quando os responsáveis pelo design do algoritmo aplicam características de determinados indivíduos a um grupo inteiro, independentemente de esses indivíduos pertencerem ou não a esse grupo. É comum em ferramentas de recrutamento e admissão.

Por exemplo: Uma ferramenta de admissão poderá favorecer candidatos de uma escola específica, discriminando outros alunos que não pertencem a essa escola.

#9. Viés Histórico

É crucial coletar dados históricos para treinar um algoritmo de ML. No entanto, se não se tiver atenção, os enviesamentos presentes nos dados históricos poderão afetar os algoritmos.

Por exemplo: Se um modelo de IA for treinado com 10 anos de dados históricos para selecionar candidatos para cargos técnicos, poderá favorecer candidatos do sexo masculino se os dados de treino incluírem mais homens do que mulheres.

#10. Viés de Rotulagem

Durante o treino de algoritmos de ML, é necessário rotular uma grande quantidade de dados. No entanto, a forma como os dados são rotulados pode variar consideravelmente, levando a inconsistências e distorções no sistema de IA.

Por exemplo: Imagine um algoritmo de IA para identificar gatos em imagens, usando caixas para os rotular. Se não tiver cuidado, o algoritmo poderá não conseguir identificar um gato numa imagem se o seu rosto não estiver visível, mas identificará aqueles com rostos de gato.

Isto significa que o algoritmo é enviesado em identificar fotos de gatos que estão de frente. Poderá não identificar o gato se a imagem for tirada de um ângulo diferente, onde o corpo aparece mas não o rosto.

#11. Viés de Exclusão

Fonte: ResearchGate

Fonte: ResearchGate

O viés de exclusão surge quando uma pessoa, grupo ou categoria é excluída, de forma não intencional ou intencional, durante a recolha de dados por serem considerados irrelevantes. Isto acontece principalmente durante a fase de preparação dos dados, quando estes são limpos e preparados para utilização.

Por exemplo: Um sistema de previsão baseado em IA que tem de determinar a popularidade de um produto durante o inverno, pode analisar os dados de vendas. Se um cientista de dados remover algumas compras registadas em outubro por considerar que estão erradas, e por considerar o período de inverno de novembro a janeiro, ele estará enviesando o algoritmo, porque existem lugares onde o inverno se estende além desses meses. Assim, o algoritmo estará enviesado para os países que têm inverno entre novembro e janeiro.

Como os Vieses são Introduzidos nos Algoritmos?

Dados de Treino

A principal causa de enviesamento algorítmico são os dados tendenciosos usados no treino de algoritmos de IA e ML. Se os dados de treino contiverem desigualdades e preconceitos, o algoritmo aprenderá esses elementos e perpetuará esses preconceitos.

Design

Ao projetar o algoritmo, o desenvolvedor pode, consciente ou inconscientemente, introduzir os seus pensamentos e preferências no sistema de IA. Como resultado, o sistema de IA será enviesado em relação a certas categorias.

Tomada de Decisão

Muitas vezes, cientistas de dados e líderes tomam decisões baseadas nas suas experiências pessoais, no seu ambiente e nas suas crenças. Estas decisões podem refletir-se nos algoritmos, causando enviesamento.

Falta de Diversidade

A falta de diversidade nas equipas de desenvolvimento pode resultar em algoritmos que não representam toda a população. Sem experiência ou exposição a outras culturas, origens, crenças e costumes, os algoritmos podem ser enviesados de uma determinada forma.

Pré-Processamento de Dados

A forma como os dados são limpos e processados também pode introduzir enviesamento algorítmico. Se estes métodos não forem projetados cuidadosamente, para combater o enviesamento, o problema pode tornar-se grave no modelo de IA.

Arquitetura

A arquitetura do modelo e o tipo de algoritmo de ML escolhido também podem introduzir preconceitos. Alguns algoritmos são mais propensos a enviesamentos do que outros, dependendo de como são projetados.

Seleção de Recursos

Os recursos escolhidos para treinar um algoritmo de IA podem ser uma fonte de enviesamento. Se a seleção não levar em conta o impacto na imparcialidade dos resultados, pode surgir enviesamento, favorecendo algumas categorias.

História e Cultura

Se um algoritmo for treinado com dados retirados da história ou de certas culturas, pode herdar enviesamentos como preconceitos, crenças e normas. Estes preconceitos podem afetar os resultados da IA, mesmo que sejam injustos e irrelevantes no presente.

Desvio de Dados

Os dados utilizados para treinar algoritmos de IA podem tornar-se irrelevantes ou obsoletos com o tempo, devido a mudanças na tecnologia ou na sociedade. Estes conjuntos de dados podem introduzir enviesamentos e prejudicar o desempenho.

Ciclos de Feedback

Alguns sistemas de IA podem comunicar com os utilizadores e adaptar-se aos seus comportamentos. Desta forma, o algoritmo pode aumentar o enviesamento já existente. Quando os preconceitos pessoais dos utilizadores são incorporados no sistema de IA, podem gerar um ciclo de feedback enviesado.

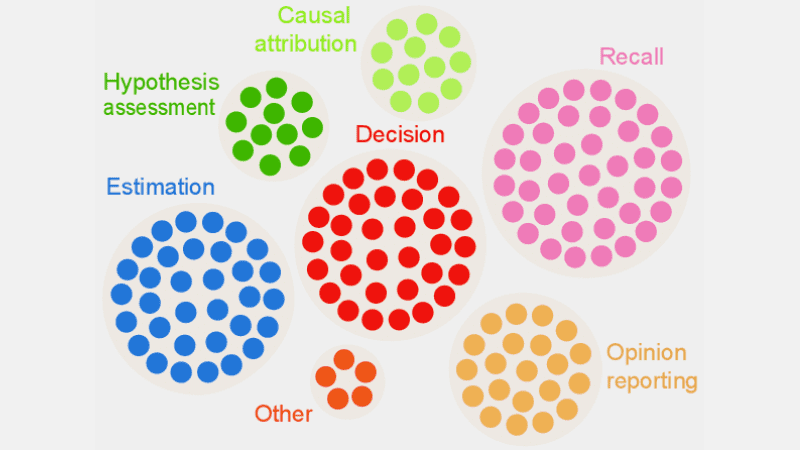

Como Detetar Enviesamentos Algorítmicos?

Definir o que é “Justo”

Para detetar resultados injustos ou enviesamentos em algoritmos, é crucial definir o que significa “justo” para o sistema de IA. Para isso, é importante considerar fatores como género, idade, etnia, orientação sexual, região e cultura.

Deve definir métricas para calcular a justiça, tais como igualdade de oportunidades, paridade preditiva e impactos. Uma vez definida a “justiça”, torna-se mais fácil identificar o que não é justo e corrigir a situação.

Auditar Dados de Treino

Analise cuidadosamente os seus dados de treino para identificar desequilíbrios e inconsistências na representação de diferentes categorias. É importante verificar a distribuição dos recursos para verificar se estes representam os dados demográficos do mundo real.

Pode usar histogramas, mapas de calor e gráficos de dispersão para visualizar os dados e identificar disparidades e padrões que não são visíveis através de análises estatísticas.

Além de auditorias internas, pode envolver especialistas e auditores externos para avaliar as distorções do sistema.

Medir o Desempenho do Modelo

Para identificar enviesamentos, meça o desempenho do seu modelo de IA para vários grupos demográficos e categorias. Divida o treino em grupos diferentes com base na etnia e género, por exemplo. Pode também usar as suas métricas de justiça para calcular as diferenças nos resultados.

Usar Algoritmos Adequados

Escolha algoritmos que promovam resultados justos e que possam resolver enviesamentos no treino de um modelo de IA. Os algoritmos com foco na justiça visam evitar enviesamentos e garantir previsões iguais em várias categorias.

Software de Deteção de Enviesamento

Pode usar ferramentas e bibliotecas especializadas em imparcialidade para detetar enviesamentos. Estas ferramentas oferecem métricas de justiça, visualizações, testes estatísticos e outras funcionalidades para identificar enviesamentos. Algumas das mais populares são o AI Fairness 360 e o IBM Fairness 360.

Solicitar Feedback dos Utilizadores

Solicite aos utilizadores e clientes feedback sobre o sistema de IA. Incentive-os a partilhar as suas avaliações honestas caso sintam qualquer tipo de tratamento injusto ou enviesamento no sistema. Estes dados ajudarão a identificar problemas que não podem ser sinalizados por ferramentas automatizadas e outros procedimentos de deteção.

Como Mitigar Enviesamentos em Algoritmos

Diversificar a Sua Empresa

Criar diversidade na sua empresa e na equipa de desenvolvimento permite detetar e remover enviesamentos mais rapidamente, já que os preconceitos podem ser rapidamente identificados pelos utilizadores afetados.

Diversifique a sua empresa, não só em termos demográficos, mas também em termos de competências e conhecimentos. Inclua pessoas de diferentes géneros, identidades, etnias, cores de pele, origens económicas e com diferentes experiências e formações.

Desta forma, pode obter uma vasta gama de perspetivas, experiências, valores culturais, gostos e aversões. Isso ajudará a melhorar a justiça dos algoritmos de IA, reduzindo os enviesamentos.

Promover a Transparência

Seja transparente com a sua equipa sobre o objetivo, algoritmos, fontes de dados e decisões relacionadas com um sistema de IA. Isto permitirá que os utilizadores compreendam como o sistema de IA funciona e por que gera determinados resultados, promovendo assim a confiança.

Algoritmos de Reconhecimento de Justiça

Use algoritmos com foco na justiça ao desenvolver o modelo, para garantir resultados justos para diferentes categorias. Isto é fundamental para sistemas de IA em setores altamente regulamentados, como finanças e saúde.

Avaliar o Desempenho do Modelo

Teste os seus modelos para analisar o desempenho da IA em vários grupos e subgrupos. Isto ajudará a compreender problemas que não são visíveis nas métricas agregadas. Pode também simular diferentes cenários para testar o desempenho nesses cenários, incluindo os mais complexos.

Seguir Diretrizes Éticas

Defina diretrizes éticas para o desenvolvimento de sistemas de IA, que respeitem a justiça, a privacidade, a segurança e os direitos humanos. Aplique estas diretrizes em toda a sua organização para aumentar a justiça e garantir que os resultados do sistema de IA sejam justos.

Definir Controlos e Responsabilidades

Defina responsabilidades claras para todos os membros da equipa envolvidos no design, desenvolvimento, manutenção e implementação do sistema de IA. Defina também controlos adequados com protocolos e estruturas rígidas para lidar com enviesamentos, erros e outras preocupações.

Além do acima exposto, realize auditorias regulares para reduzir os enviesamentos e melhorar continuamente. Mantenha-se atualizado com as últimas mudanças em tecnologia, demografia e outros fatores.

Exemplos Reais de Enviesamentos Algorítmicos

#1. Algoritmo da Amazon

A Amazon é líder no setor de comércio eletrónico. No entanto, a sua ferramenta de recrutamento baseada em IA para avaliar candidatos a empregos demonstrou enviesamento de género. O sistema de IA foi treinado utilizando currículos de candidatos anteriores em funções técnicas.

Os dados incluíam um maior número de candidatos do sexo masculino, o que a IA aprendeu. Desta forma, favoreceu involuntariamente candidatos do sexo masculino para cargos técnicos em detrimento de mulheres, que estavam sub-representadas. A Amazon descontinuou a ferramenta em 2017, apesar dos seus esforços para reduzir o enviesamento.

#2. Algoritmos Racistas de Saúde nos EUA

Um algoritmo utilizado por hospitais nos EUA para prever pacientes que precisavam de cuidados adicionais foi fortemente enviesado contra pacientes negros. O sistema avaliava as necessidades médicas dos pacientes com base no seu histórico de despesas com saúde, associando o custo às necessidades médicas.

O algoritmo não considerou como pacientes brancos e negros pagavam pelas suas necessidades de saúde. Apesar de terem doenças não controladas, os pacientes negros pagavam principalmente as emergências. Desta forma, foram classificados como pacientes mais saudáveis e não foram considerados para cuidados adicionais, em comparação com os pacientes brancos.

#3. Algoritmo Discriminatório do Google

O sistema de anúncios online do Google foi acusado de discriminação. Foram apresentados anúncios de cargos com salários elevados, como CEOs, para homens em maior número do que para mulheres. Mesmo que 27% dos CEOs nos EUA sejam mulheres, a representação destas no Google é muito menor, cerca de 11%.

O algoritmo poderia ter obtido este resultado através da análise do comportamento do utilizador. Se pessoas que visualizam e clicam em anúncios de cargos com salários elevados forem na sua maioria homens, o algoritmo de IA irá apresentar estes anúncios mais para homens do que para mulheres.

Conclusão

O enviesamento algorítmico em sistemas de ML e IA pode levar a resultados injustos que afetam indivíduos em várias áreas, como saúde, segurança cibernética, comércio eletrónico, eleições e emprego. Pode levar à discriminação com base no género, etnia, demografia e orientação sexual.

É importante reduzir os preconceitos nos algoritmos de IA e ML para promover resultados justos. As informações acima devem ajudá-lo a detetar e reduzir enviesamentos, para que possa criar sistemas de IA justos para todos.

Pode também ler sobre Governança de IA.