Com que frequência você confia em chatbots ou bots baseados em Inteligência Artificial (IA) para realizar o trabalho ou responder às suas perguntas?

Se sua resposta for ‘muito!’ ou ‘o tempo todo!’, você tem um motivo para se preocupar😟.

Quer você seja um estudante de pesquisa que usa bots de IA religiosamente para pesquisar sua papelada ou um programador tentando gerar códigos apenas usando IA, as chances de imprecisão nos resultados gerados pela IA são muito altas – principalmente por causa de inconsistências ou dados delirantes nos dados da IA. dados de treinamento.

Embora os modelos de IA e aprendizado de máquina (ML) estejam transformando o mundo, assumindo tarefas redundantes e resolvendo muitos problemas com a automação, ainda há trabalho a fazer quando se trata de gerar resultados precisos com base nos prompts fornecidos.

Se você gastar bastante tempo usando geradores de conteúdo e chatbots, não demorará muito para perceber que está recebendo respostas falsas, irrelevantes ou simplesmente inventadas. Esses casos são chamados de alucinações ou confabulações de IA e provam ser um grande problema para organizações e indivíduos que dependem de bots de IA generativos.

Quer você tenha tido alucinações de IA ou não e queira saber mais, este artigo se aprofunda no assunto. Veremos o que significa alucinação de IA, por que acontece, exemplos e se pode ser corrigido.

Vamos!

últimas postagens

O que é alucinação de IA?

Uma alucinação de IA ocorre quando um modelo de IA ou Modelo de Linguagem Grande (LLM) gera informações falsas, imprecisas ou ilógicas. O modelo de IA gera uma resposta confiante que realmente não corresponde ou se alinha com seus dados de treinamento e representa os dados como fatos, apesar de não fazer sentido lógico ou raciocínio!

E dizem que errar é humano!😅

Ferramentas e modelos de IA, como ChatGPT, normalmente são treinados para prever as palavras que melhor correspondem à consulta feita. Embora os bots geralmente gerem respostas factuais e precisas, às vezes esse algoritmo faz com que faltem raciocínio, fazendo com que os chatbots cuspam inconsistências factuais e declarações falsas.

Em outras palavras, os modelos de IA às vezes “alucinam” a resposta na tentativa de agradar você (o usuário) – precisando ser mais tendenciosos, parciais, especializados ou suficientes.

As alucinações de IA podem variar de pequenas inconsistências a respostas totalmente falsas ou fabricadas. Aqui estão os tipos de alucinações de IA que você pode experimentar:

#1. Contradição de frase: Isso acontece quando um modelo LLM gera uma frase que contradiz completamente a frase reivindicada anteriormente.

#2. Contradição factual: Este tipo de alucinação ocorre quando o modelo de IA apresenta informações falsas ou fictícias como fatos.

#3. Contradição de prompt: esse tipo de alucinação acontece quando a saída contradiz o prompt para o qual ela gera uma saída. Por exemplo, se a solicitação for “Escreva um convite para meus amigos para minha festa de aniversário”. O modelo pode gerar um resultado como “Feliz aniversário, mamãe e papai”.

#4. Alucinações aleatórias ou irrelevantes: essa alucinação acontece quando o modelo gera resultados completamente irrelevantes para o prompt fornecido. Por exemplo, se a pergunta for “O que há de especial na cidade de Nova York?” Você pode receber uma mensagem dizendo: “Nova York é uma das cidades mais populosas da América. Os cães são os animais mais leais e os melhores amigos do homem.”

Leia também: Como a pesquisa generativa de IA está mudando os mecanismos de pesquisa

Exemplos de alucinações de IA

As alucinações de IA têm alguns dos exemplos e incidentes mais notáveis que você não deve perder. Aqui estão exemplos infames de alucinações de IA:

- O chatbot do Google, Bard, afirmou falsamente que o Telescópio Espacial James Webb obteve as primeiras imagens do mundo de um exoplaneta que não pertence ao nosso sistema solar.

- A demonstração Galactica LLM da Meta em 2022, projetada para estudantes e pesquisadores científicos, forneceu a seus usuários informações imprecisas e um artigo falso quando solicitado a redigir um artigo sobre a criação de avatares.

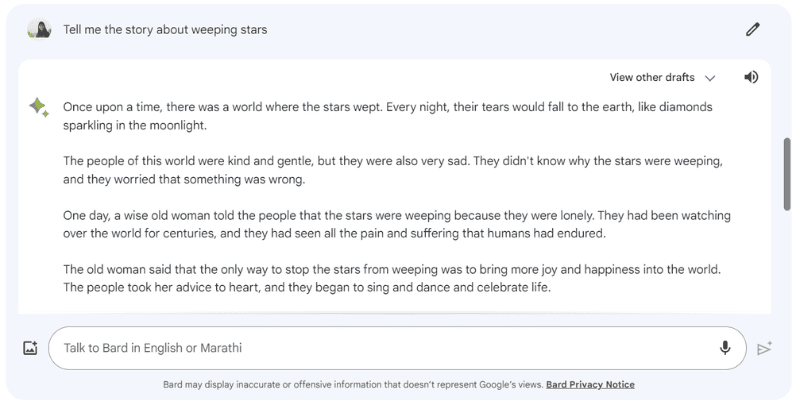

Aqui está um exemplo do Google Bard alucinando uma resposta quando eu lhe dei a mensagem: “Conte-me a história das estrelas choronas”, que realmente não existe.

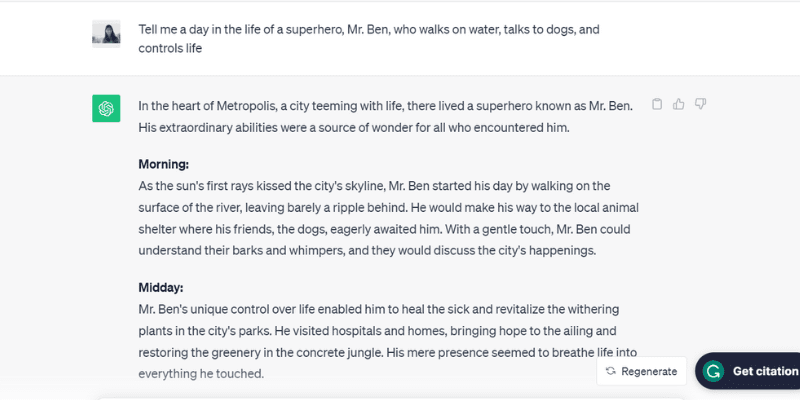

Aqui está outro exemplo testado de ChatGPT (GPT-3.5) alucinando ao falar sobre uma pessoa irreal, Sr. Ben, quando eu lhe dei a instrução: “Conte-me um dia na vida de um super-herói, Sr. água, fala com cães e controla a vida.”

O ChatGPT literalmente recrutou a rotina completa do dia, da manhã à noite, do Sr. Ben, que na verdade não existe – mas seguiu o prompt que foi enviado a ele, que é uma das razões por trás das alucinações de IA.

Fale sobre muito feliz em agradar!

Bem, quais são as razões, vejamos mais algumas razões que causam alucinações na IA.

Por que ocorrem alucinações de IA?

Existem várias razões e causas técnicas por trás das alucinações de IA. Aqui estão alguns dos possíveis motivos:

- Dados de baixa qualidade, insuficientes ou desatualizados: LLMs e modelos de IA dependem fortemente de dados de treinamento. Conseqüentemente, eles são tão bons quanto os dados nos quais foram treinados. Se a ferramenta de IA tiver erros, inconsistências, preconceitos ou ineficiência em seus dados de treinamento ou se simplesmente não entender o prompt solicitado, isso criará alucinações de IA, pois a ferramenta gera uma saída a partir de um conjunto de dados limitado.

- Overfitting: Sendo treinado num conjunto de dados limitado, o modelo de IA pode tentar memorizar as instruções e os resultados apropriados – tornando-o incapaz de gerar ou generalizar novos dados de forma eficaz, levando a alucinações de IA.

- Contexto de entrada: As alucinações de IA também podem ocorrer devido a instruções pouco claras, imprecisas, inconsistentes ou contraditórias. Embora o conjunto de dados de treinamento do modelo de IA não esteja nas mãos dos usuários, a entrada que eles inserem como um prompt está. Portanto, é fundamental fornecer instruções claras para evitar alucinações de IA.

- Uso de expressões idiomáticas ou gírias: se o prompt consistir em expressões idiomáticas ou gírias, há grandes chances de alucinações de IA, especialmente se o modelo não for treinado para tais palavras ou gírias.

- Ataques adversários: Às vezes, os invasores inserem deliberadamente avisos projetados para confundir os modelos de IA, corrompendo seus dados de treinamento e resultando em alucinações de IA.

Implicações negativas das alucinações de IA

As alucinações de IA são grandes preocupações éticas com consequências significativas para indivíduos e organizações. Aqui estão os diferentes motivos que tornam as alucinações de IA um grande problema:

- Propagação de desinformação: Alucinações de IA devido a avisos incorretos ou inconsistências nos dados de treinamento podem levar à disseminação em massa de desinformação, afetando uma ampla gama de indivíduos, organizações e agências governamentais.

- Desconfiança entre os usuários: quando a desinformação alucinada pela IA se espalha como um incêndio na Internet, fazendo com que pareça oficial e escrita por humanos, ela corrói a confiança do usuário, tornando difícil para os usuários confiar nas informações na Internet.

- Danos ao usuário: além de preocupações éticas e de enganar os indivíduos, as alucinações de IA também podem potencialmente prejudicar os seres humanos, espalhando informações erradas sobre alguns problemas e tópicos sérios, como doenças, suas curas ou dicas simples para distinguir entre um cogumelo comestível venenoso mortal e um cogumelo comestível saudável. Mesmo uma ligeira desinformação ou imprecisão pode colocar em risco a vida de um ser humano.

Melhores práticas para detectar e prevenir alucinações de IA

Olhando para as implicações negativas das alucinações de IA acima mencionadas, preveni-las é crucial a todo custo. Embora as empresas proprietárias desses modelos de IA estejam trabalhando rigorosamente para eliminar ou reduzir as alucinações de IA, tomar as medidas máximas de nossa parte, como usuários, é muito importante.

Com base em um pouco de pesquisa, minha experiência e tentativa e erro, listei algumas estratégias para detectar e prevenir alucinações de IA na próxima vez que você usar um chatbot ou interagir com um Large Language Model (LLM).

#1. Use dados de treinamento representativos e diversificados

Como usuário, é fundamental usar LLMs com um conjunto diversificado de dados de treinamento que represente o mundo real, reduzindo a probabilidade de resultados serem tendenciosos, imprecisos ou inventados.

Ao mesmo tempo, os proprietários das empresas devem garantir a atualização e expansão regulares dos conjuntos de dados de formação do modelo de IA para ter em conta e estar atualizados sobre os eventos culturais, políticos e outros eventos em evolução.

#2. Limite os resultados ou respostas

Como usuário, você pode limitar o número de respostas potenciais que uma ferramenta de IA pode gerar, fornecendo-lhe uma solicitação específica sobre o tipo de resposta que deseja.

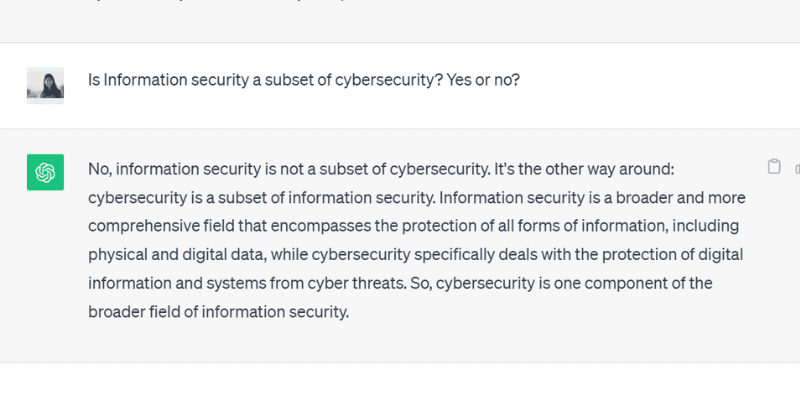

Por exemplo, você pode solicitar especificamente um prompt e ordenar que o modelo responda apenas sim ou não. Ou você também pode fornecer várias opções no prompt para a ferramenta escolher, limitando sua possibilidade de se desviar da resposta real e ter alucinações.

Quando fiz uma pergunta ao ChatGPT GPT 3.5 com sim ou não, ele gerou com precisão esta saída:

#3. Embale e baseie o modelo com dados relevantes

Você não pode esperar que um ser humano forneça uma solução para qualquer problema ou questão específica sem conhecimento prévio ou sem fornecer um contexto específico. Da mesma forma, um modelo de Inteligência Artificial é tão bom quanto o conjunto de dados de treinamento que você alimenta nele.

Fundamentar ou empacotar os dados de treinamento de um modelo de IA com dados e informações relevantes e específicos do setor fornece ao modelo contexto e pontos de dados adicionais. Este contexto adicional ajuda o modelo de IA a melhorar a sua compreensão, permitindo-lhe gerar respostas precisas, sensatas e contextuais em vez de respostas alucinadas.

#4. Crie modelos de dados para o modelo de IA seguir

Fornecer um modelo de dados ou um exemplo de fórmula ou cálculo específico em um formato predefinido pode ajudar principalmente o modelo de IA a gerar respostas precisas, alinhando-se com as diretrizes prescritas.

Depender de diretrizes e modelos de dados reduz a probabilidade de alucinação por modelos de IA e garante consistência e precisão nas respostas geradas. Assim, fornecer um modelo de referência no formato de uma tabela ou exemplo pode realmente orientar o modelo de IA no cálculo – eliminando casos de alucinação.

#5. Seja muito específico com sua solicitação, atribuindo ao modelo uma função específica

Atribuir funções específicas ao modelo de IA é uma das formas mais brilhantes e eficientes de prevenir alucinações. Por exemplo, você pode fornecer instruções como “Você é um guitarrista experiente e habilidoso” ou “Você é um matemático brilhante”, seguido de sua pergunta específica.

A atribuição de funções orienta o modelo a fornecer a resposta que você deseja, em vez de respostas alucinadas inventadas.

E não se preocupe. Você ainda pode se divertir com a IA (não importa as alucinações). Veja como criar você mesmo uma arte espiral viral de IA!

#6. Teste com temperatura

A temperatura desempenha um papel crítico na determinação do grau de alucinações ou respostas criativas que um modelo de IA pode gerar.

Embora uma temperatura mais baixa normalmente signifique resultados determinísticos ou previsíveis, uma temperatura mais alta significa que o modelo de IA tem maior probabilidade de gerar respostas aleatórias e alucinar.

Várias empresas de IA fornecem uma barra ou controle deslizante de ‘Temperatura’ com suas ferramentas para que os usuários ajustem as configurações de temperatura de acordo com suas preferências.

Ao mesmo tempo, as empresas também podem definir uma temperatura padrão, permitindo que a ferramenta gere respostas sensatas e alcance o equilíbrio certo entre precisão e criatividade.

#7. Sempre verifique

Por último, confiar 100% em um resultado gerado por IA sem dupla verificação ou verificação de fatos não é uma jogada inteligente.

Embora as empresas e pesquisadores de IA resolvam o problema da alucinação e desenvolvam modelos que evitem esse problema, como usuário, é crucial verificar as respostas que um modelo de IA gera antes de usá-lo ou acreditar completamente nele.

Portanto, além de usar as práticas recomendadas mencionadas acima, desde a elaboração de seu prompt com especificações até a adição de exemplos em seu prompt para orientar a IA, você deve sempre verificar e cruzar a saída que um modelo de IA gera.

Você pode corrigir ou remover completamente as alucinações de IA? A opinião de um especialista

Embora o controle das alucinações da IA dependa do aviso que lhe fornecemos, às vezes o modelo gera resultados com tanta confiança que torna difícil discernir entre o que é falso e o que é verdadeiro.

Então, em última análise, é possível corrigir ou prevenir totalmente as alucinações da IA?

Quando esta pergunta foi feitaSuresh Venkatasubramanian, professor da Universidade Brown, respondeu que se as alucinações de IA podem ser evitadas ou não é um “ponto de pesquisa ativa”.

A razão por trás disso, explicou ainda, é a natureza desses modelos de IA – quão complexos, intrincados e frágeis são esses modelos de IA. Mesmo uma pequena alteração na entrada do prompt pode alterar significativamente as saídas.

Embora Venkatasubramanian considere resolver o problema das alucinações de IA um ponto de pesquisa, Jevin West, professor da Universidade de Washington e cofundador do Centro para um Público Informado, acredita que as alucinações de IA nunca desaparecerão.

West acredita que é impossível fazer engenharia reversa de alucinações que ocorrem em bots de IA ou chatbots. E, portanto, as alucinações de IA podem sempre estar presentes como característica intrínseca da IA.

Além disso, Sundar Pichai, CEO do Google, disse em um entrevista com CBS que todos que usam IA enfrentam alucinações, mas ninguém na indústria ainda resolveu o problema das alucinações. Quase todos os modelos de IA enfrentam esse problema. Ele ainda afirmou e garantiu que o campo da IA irá progredir em breve quando se trata de superar as alucinações da IA.

Ao mesmo tempo, Sam Altman, CEO da OpenAI, fabricante do ChatGPT, visitou o Instituto Indraprastha de Tecnologia da Informação da Índia, Delhi, em junho de 2023, onde observou que o problema de alucinação de IA estaria em um lugar muito melhor em um ano e meio para dois anos.

Ele acrescentou ainda que o modelo exigiria aprender a diferença entre precisão e criatividade e quando usar uma ou outra.

Empacotando

A alucinação da IA tem atraído bastante atenção nos últimos anos e é uma área de foco para empresas e pesquisadores que tentam resolvê-la e superá-la o mais cedo possível.

Embora a IA tenha feito progressos notáveis, não está imune a erros, e o problema das alucinações da IA coloca grandes desafios a vários indivíduos e indústrias, incluindo os cuidados de saúde, a geração de conteúdos e a indústria automóvel.

Embora os pesquisadores estejam fazendo a sua parte, também é nossa responsabilidade como usuários fornecer avisos específicos e precisos, adicionar exemplos e fornecer modelos de dados para aproveitar respostas válidas e sensatas, evitar mexer nos dados de treinamento do modelo de IA e evitar alucinações.

Mesmo que as alucinações de IA possam ser completamente curadas ou corrigidas, ainda permanece uma questão; Pessoalmente, acredito que há esperança e que podemos continuar a utilizar sistemas de IA para beneficiar o mundo de forma responsável e segura.

A seguir, exemplos de Inteligência Artificial (IA) em nosso dia a dia.