Se o seu interesse reside na Inteligência Artificial, este artigo certamente o guiará por suas complexidades. Meu objetivo é orientá-lo na sua jornada pelo universo das plataformas LLMOps, oferecendo uma compreensão clara sobre as ferramentas essenciais para testar, aprimorar e implementar Modelos de Linguagem de Grande Escala (LLMs).

As plataformas destacadas nesta análise desempenham um papel crucial na maximização do potencial dos modelos de linguagem, apresentando soluções inovadoras para o desenvolvimento e gerenciamento.

Empresas renomadas, como Google, OpenAI e Microsoft, utilizam plataformas LLMOps para assegurar testes rigorosos, refinamento contínuo e implantação eficaz dos seus modelos de linguagem, resultando em desempenhos confiáveis e precisos.

Consciente de que LLMOps pode ser um conceito novo para muitos, começaremos por construir uma base sólida, definindo o significado, as funções e os benefícios das LLMOps.

Com este alicerce, poderemos então atingir o objetivo principal: identificar as ferramentas ideais para cada leitor, considerando suas necessidades específicas. A lista principal que apresentamos neste artigo será o seu guia nesta jornada.

O Que São LLMOps?

LLMOps, ou Operações de Modelos de Linguagem, é o conjunto de práticas para gerenciar, implementar e aperfeiçoar modelos de linguagem de grande escala, como os utilizados em IA. As LLMOps abrangem ferramentas e processos para treinar, testar e manter esses modelos, assegurando seu bom funcionamento e precisão ao longo do tempo.

Apesar de ser fácil criar protótipos de LLMs, sua utilização em produtos comerciais apresenta dificuldades. O ciclo de desenvolvimento de um LLM envolve etapas complexas, como preparação de dados, ajuste fino e implementação, que requerem um trabalho de equipe contínuo. As LLMOps cobrem todo esse ciclo, garantindo experimentação, implementação e aperfeiçoamento sem problemas.

É fundamental entender o que é uma Plataforma LLMOps, pois isso lhe proporcionará uma clareza precisa e o guiará para resultados positivos após a leitura.

Uma plataforma LLMOps promove a colaboração entre cientistas de dados e engenheiros, facilitando a exploração iterativa de dados. Permite o trabalho em equipe em tempo real, rastreamento de experimentos, gerenciamento de modelos e implantação controlada de LLMs. As LLMOps automatizam operações, sincronização e monitoramento em todo o ciclo de vida de aprendizado de máquina (ML).

Como Funcionam as LLMOps?

As plataformas LLMOps simplificam todo o ciclo de vida dos modelos de linguagem. Elas centralizam a preparação de dados, permitem experimentação e ajuste fino para tarefas específicas. Estas plataformas facilitam a implementação tranquila, monitoramento contínuo e transição suave entre versões.

A colaboração é incentivada, os erros são minimizados pela automação e o refinamento contínuo é suportado. Em resumo, as LLMOps otimizam o gerenciamento de modelos de linguagem para diversas aplicações.

Benefícios das LLMOps

As principais vantagens que destaco são eficiência, precisão e escalabilidade. Abaixo, apresento uma descrição detalhada dos benefícios que as LLMOps oferecem:

- Eficiência: As plataformas LLMOps otimizam todo o ciclo de desenvolvimento, teste e implementação de modelos de linguagem, poupando tempo e esforço.

- Colaboração: Estas plataformas promovem uma colaboração fluida entre cientistas de dados, engenheiros e outras partes interessadas, fomentando um trabalho em equipe eficaz.

- Precisão: As LLMOps mantêm e melhoram a precisão dos modelos ao longo do tempo, monitorando e refinando continuamente os modelos.

- Automação: As LLMOps automatizam várias tarefas, como pré-processamento e monitoramento de dados, reduzindo a necessidade de intervenção manual.

- Escalabilidade: Ao facilitar a expansão eficiente dos modelos, as plataformas LLMOps conseguem lidar com cargas de trabalho e demandas crescentes.

- Facilidade de Implantação: As LLMOps garantem que os modelos sejam integrados em aplicações ou sistemas sem problemas, minimizando os desafios relacionados à implantação.

Em essência, as LLMOps melhoram a eficiência, precisão e escalabilidade, além de promover a colaboração, automação e implantação contínua.

Avançaremos agora para a nossa lista de plataformas. Esta lista serve como um guia da etechpt.com, mas a decisão de qual plataforma melhor se adequa às suas necessidades está em suas mãos.

Dify

Está intrigado com o rápido avanço das tecnologias LLM, como o GPT-4, e entusiasmado com o seu potencial prático? Dify foi desenvolvido para você. Ele permite que desenvolvedores e até mesmo pessoas sem conhecimento técnico profundo criem rapidamente aplicativos úteis usando modelos de linguagem abrangentes. Estes aplicativos são fáceis de usar e estão configurados para melhoria contínua.

Características Principais:

- Plataforma LLMOps intuitiva: Desenvolva aplicativos de IA facilmente usando o GPT-4 e gerencie-os visualmente.

- IA contextualizada com seus dados: Use documentos, conteúdo da web ou notas do Notion como contexto para IA. Dify cuida do pré-processamento e mais, economizando tempo de desenvolvimento.

- Liberte o potencial do LLM: Dify garante acesso contínuo aos modelos, incorporação de contexto, controle de custos e anotação de dados para uma criação de IA suave.

- Modelos prontos: Escolha entre modelos de diálogo e geração de texto, prontos para serem personalizados para suas aplicações específicas.

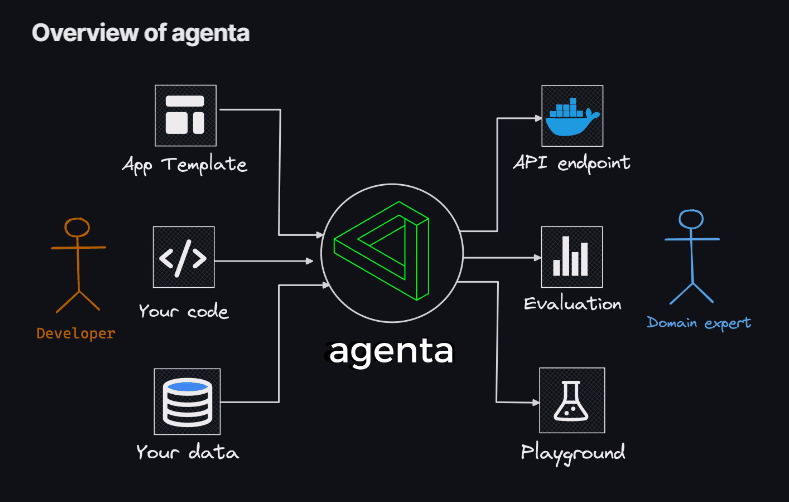

Agenta

Se procura flexibilidade para criar aplicações LLM através de codificação, sem as restrições de modelos, bibliotecas ou estruturas, então Agenta é a sua solução. Agenta surge como uma plataforma de código aberto projetada para otimizar o processo de colocação em produção de aplicações complexas de modelos de linguagem (aplicações LLM).

Com Agenta, pode experimentar e criar rapidamente versões de prompts, parâmetros e estratégias complexas, incluindo aprendizagem no contexto com incorporações, agentes e lógica de negócios personalizada.

Características Principais:

- Exploração de Parâmetros: Especifique os parâmetros da sua aplicação diretamente no seu código e experimente-os facilmente através de uma plataforma web intuitiva.

- Avaliação de Desempenho: Avalie a eficácia da sua aplicação em conjuntos de testes usando uma variedade de metodologias, como correspondência exata, AI Critic, avaliação humana e muito mais.

- Estrutura de Testes: Crie conjuntos de testes sem esforço usando a interface do usuário, seja fazendo upload de CSVs ou conectando-se aos seus dados através da nossa API.

- Ambiente Colaborativo: Promova o trabalho em equipe compartilhando sua aplicação com colaboradores e convidando seus comentários e insights.

- Implantação Facilitada: Inicie sua aplicação como uma API com um único clique, otimizando o processo de implantação.

Além disso, Agenta promove a colaboração com especialistas para a engenharia e avaliação de prompts. Outro destaque é a capacidade de Agenta avaliar sistematicamente as suas aplicações LLM e facilitar a implantação com um único clique.

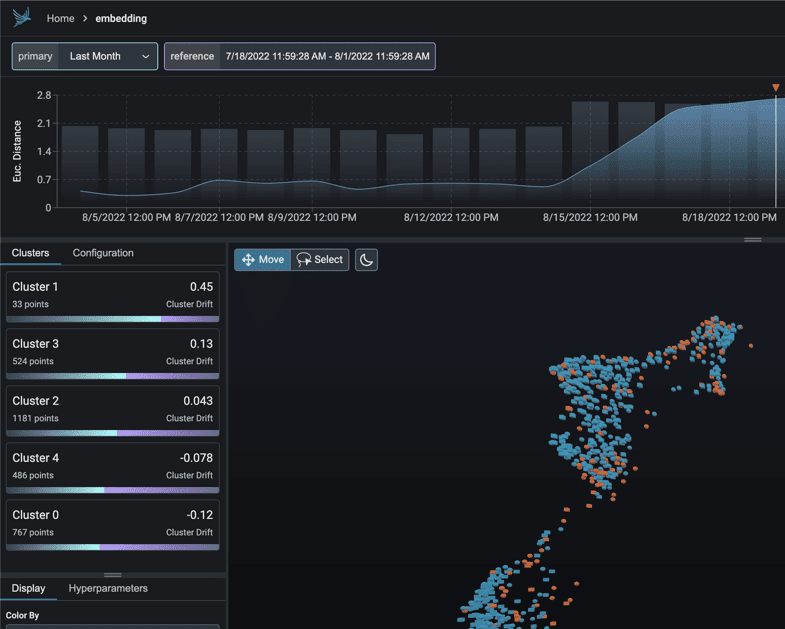

Phoenix

Embarque numa jornada de insights MLOps com Phoenix. Esta ferramenta eficaz revela a observabilidade do desempenho dos modelos, desvio e qualidade dos dados, sem necessidade de configurações complexas.

Como uma biblioteca Python focada em notebooks, Phoenix utiliza embeddings para descobrir complexidades ocultas em LLMs, CV, PNL e modelos tabulares. Potencialize seus modelos com os recursos incomparáveis que Phoenix oferece.

Características Principais:

- Investigação de Deriva Incorporada: Analise nuvens de pontos UMAP durante instâncias de distância euclidiana substancial e identifique clusters de deriva.

- Análise de Desvio e Desempenho via Cluster: Desconstrua seus dados em clusters de desvio significativo ou desempenho abaixo da média através do HDBSCAN.

- Análise Exploratória de Dados Baseada em UMAP: Sobreponha suas nuvens de pontos UMAP com base nos atributos, desvios e desempenho do seu modelo, revelando segmentos problemáticos.

LangKit

LangKit é um kit de ferramentas de código aberto para métricas de texto projetado para monitorar efetivamente modelos de linguagem de grande escala.

A motivação por trás da criação de LangKit vem da constatação de que a transformação de modelos de linguagem, incluindo LLMs, para produção acarreta vários riscos. As inúmeras combinações possíveis de entradas, que levam a resultados igualmente numerosos, representam um desafio considerável.

Características Principais:

- Análise de Injeção de Prompt: Avalie pontuações de similaridade com ataques de injeção de prompt conhecidos.

- Análise de Sentimento: Avalie o tom de sentimento do texto.

- Avaliação da Qualidade do Texto: Avalie a legibilidade, complexidade e pontuações.

- Detecção de Jailbreak: Identifique pontuações de similaridade com tentativas de jailbreak conhecidas.

- Análise de Toxicidade: Detecta níveis de toxicidade no conteúdo fornecido.

A natureza não estruturada do texto complica ainda mais as questões no âmbito da observabilidade, um desafio que merece resolução. Afinal, a ausência de insights sobre o comportamento de um modelo pode gerar consequências significativas.

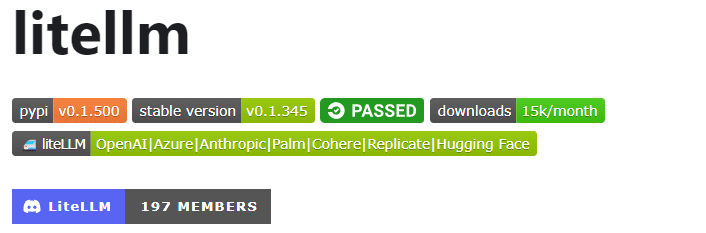

LiteLLM

Com LiteLLM, simplifique suas interações com várias APIs LLM – Anthropic, Huggingface, Cohere, Azure OpenAI, e mais – usando um pacote leve no formato OpenAI.

Este pacote otimiza o processo de chamada de endpoints API de provedores como OpenAI, Azure, Cohere e Anthropic. Ele traduz as entradas para os endpoints de conclusão e incorporação do provedor relevante, assegurando resultados uniformes. Pode sempre aceder às respostas de texto em [‘choices’][0][‘message’][‘content’].

Características Principais:

- Chamada de API LLM Simplificada: Simplifica a interação com APIs LLM como Anthropic, Cohere, Azure OpenAI, etc.

- Pacote Leve: Uma solução compacta para chamar endpoints OpenAI, Azure, Cohere, Anthropic e API.

- Tradução de Entrada: Gerencia a tradução de entradas para os endpoints de conclusão e incorporação do respetivo provedor.

- Mapeamento de Exceções: Mapeia exceções comuns entre provedores para tipos de exceção OpenAI, para tratamento de erros padronizado.

Adicionalmente, o pacote inclui um recurso de mapeamento de exceções. Alinha exceções padrão em diferentes provedores com tipos de exceção OpenAI, garantindo consistência no tratamento de erros.

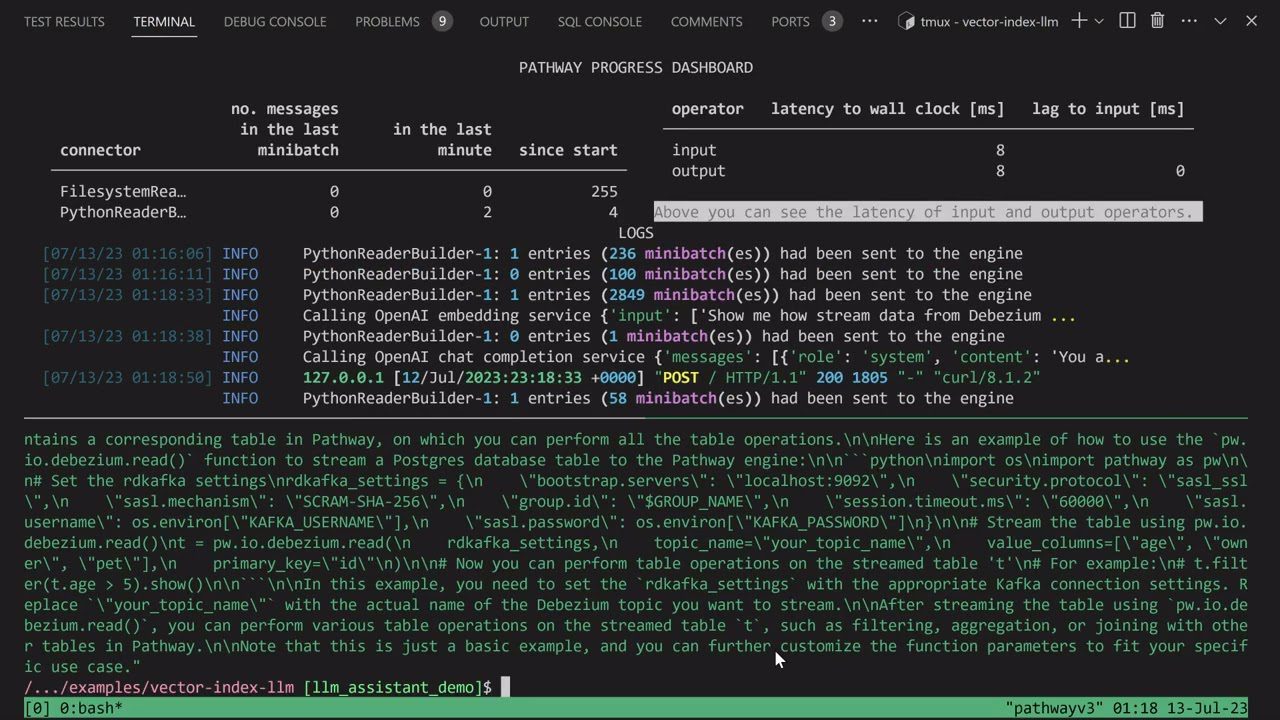

LLM App

Embarque na jornada de criação do seu chatbot Discord AI, enriquecido com a capacidade de responder perguntas, ou explore ideias semelhantes para bots de IA. Todas essas funcionalidades cativantes convergem através do LLM App.

Apresento o Pathways LLM-App, uma biblioteca Python meticulosamente projetada para acelerar o desenvolvimento de aplicativos de IA inovadores.

Características Principais:

- Criado para Modelos de ML Locais: O LLM App é configurado para ser executado com modelos de ML locais, dentro dos limites da organização.

- Tratamento de Dados em Tempo Real: Esta biblioteca gerencia fontes de dados em tempo real, como feeds de notícias, APIs e fluxos de dados Kafka, com permissões de utilizador e segurança robusta.

- Sessões de Utilizador Tranquilas: O processo de criação de consultas da biblioteca gere sessões de utilizador de forma eficiente, assegurando interações contínuas.

Este recurso excepcional permite fornecer respostas instantâneas que refletem interações humanas ao responder às dúvidas dos utilizadores, aproveitando os insights mais recentes contidos nas suas fontes de dados.

LLMFlows

LLMFlows surge como uma estrutura adaptada para simplificar, esclarecer e trazer transparência ao desenvolvimento de aplicações de Modelos de Linguagem de Grande Escala (LLM), como chatbots, sistemas de resposta a perguntas e agentes.

A complexidade pode ser ampliada em cenários do mundo real devido às relações complexas entre prompts e chamadas LLM.

Os criadores do LLMFlows imaginaram uma API explícita que permite aos utilizadores criar código limpo e compreensível. Esta API simplifica a criação de interações LLM complexas, garantindo um fluxo contínuo entre vários modelos.

Características Principais:

- Configure aulas LLM perfeitamente, selecionando meticulosamente modelos, parâmetros e configurações específicas.

- Garanta interações LLM robustas com novas tentativas automáticas em caso de falhas nas chamadas de modelo, garantindo confiabilidade.

- Otimize o desempenho e a eficiência utilizando fluxos assíncronos para execução paralela de LLMs quando as entradas estiverem disponíveis.

- Incorpore funções personalizadas de manipulação de strings diretamente nos fluxos, facilitando transformações de texto personalizadas além das chamadas LLM.

- Mantenha controlo e supervisão completos sobre aplicações baseadas em LLM com retornos de chamada, oferecendo monitorização abrangente e visibilidade dos processos de execução.

As classes LLMFlows fornecem aos utilizadores autoridade total sem prompts ocultos ou chamadas LLM.

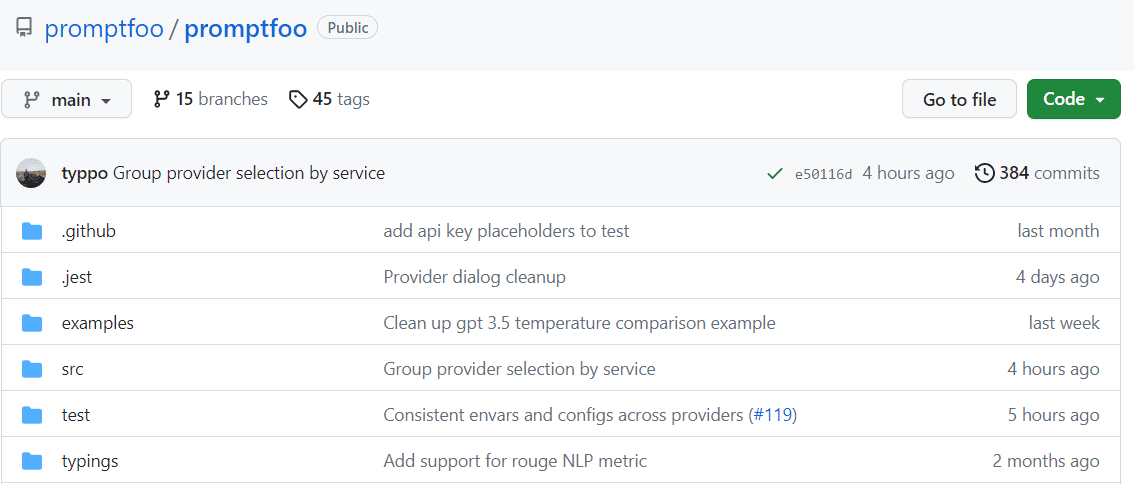

Promptfoo

Acelere avaliações através de armazenamento em cache e testes simultâneos usando promptfoo. Ele fornece uma interface de linha de comando (CLI) e uma biblioteca que permitem avaliar a qualidade da saída do LLM.

Características Principais:

- Confiabilidade Comprovada: O Promptfoo foi cuidadosamente criado para avaliar e aprimorar aplicações LLM que servem mais de 10 milhões de utilizadores num ambiente de produção. As ferramentas fornecidas são flexíveis e adaptáveis a várias configurações.

- Casos de Teste Fáceis de Usar: Defina avaliações sem codificar ou usar notebooks complicados. Uma abordagem simples e declarativa simplifica o processo.

- Flexibilidade de Linguagem: Quer esteja a usar Python, Javascript ou qualquer outra linguagem, o promptfoo adapta-se à sua preferência.

Adicionalmente, o promptfoo permite testes sistemáticos de prompts em casos de teste predefinidos, ajudando a avaliar a qualidade e identificar regressões, facilitando a comparação lado a lado dos resultados do LLM.

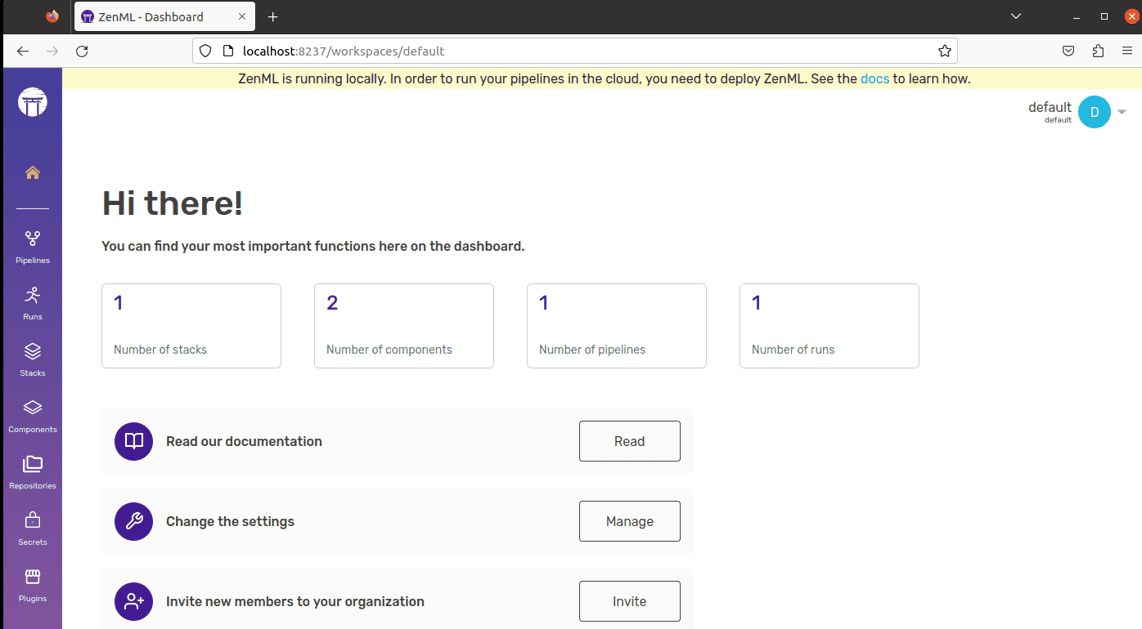

ZenML

Diga olá ao ZenML – uma ferramenta adaptável e de código aberto projetada para facilitar o mundo dos pipelines de aprendizagem de máquina para profissionais e organizações. Imagine ter uma ferramenta que lhe permite construir pipelines de aprendizagem de máquina adequados para o mundo real, independentemente da complexidade do seu projeto.

ZenML separa o material técnico do código, facilitando a colaboração entre desenvolvedores, cientistas de dados, especialistas em MLOps e engenheiros de ML. Isso significa que os seus projetos podem ir da fase de ideia até estarem prontos para a ação mais facilmente.

Características Principais:

- Para Cientistas de Dados: Concentre-se na criação e teste de modelos enquanto o ZenML prepara o seu código para uso no mundo real.

- Para Especialistas em Infraestrutura MLOps: Configure, gerencie e implemente sistemas complexos rapidamente para que seus colegas possam usá-los sem complicações.

- Para Engenheiros de ML: Administre todas as etapas do seu projeto de aprendizagem de máquina, do início ao fim, com a ajuda do ZenML. Isso significa menos transferência de trabalho e mais clareza na jornada da sua organização.

ZenML foi criado para todos – seja um profissional ou parte de uma organização. Ele vem com uma forma de escrever código projetada para tarefas de aprendizagem de máquina e funciona bem com qualquer serviço ou ferramenta em nuvem que use. Além disso, ajuda-o a gerenciar o seu projeto num só lugar, para que não tenha de se preocupar em lidar com várias coisas diferentes. Basta escrever o seu código uma vez e usá-lo facilmente noutros sistemas.

Considerações Finais

Nesta jornada, lembre-se sempre de que cada plataforma apresenta uma chave distinta capaz de desbloquear as suas aspirações de IA. A sua escolha tem o poder de moldar o seu caminho, então escolha com sabedoria!

Pode também explorar algumas ferramentas de IA para que os desenvolvedores criem aplicações mais rapidamente.