Para quem não tem experiência com programação, a criação de um web scraper pode parecer uma tarefa complexa. No entanto, existem diversas opções de software de web scraping acessíveis tanto para programadores quanto para não programadores. Esses softwares são ferramentas desenvolvidas especificamente para coletar dados relevantes de sites, sendo úteis para qualquer pessoa que necessite obter informações da internet. Os dados coletados são geralmente armazenados em um arquivo local no computador ou em um banco de dados. Essa técnica de coleta de dados da web é feita de forma automatizada. Apresentamos uma lista com as 31 melhores ferramentas gratuitas para web scraping.

31 Melhores Ferramentas de Web Scraping

Aqui está uma seleção das melhores ferramentas para web scraping disponíveis. Esta lista inclui tanto ferramentas de código aberto quanto soluções comerciais, acompanhadas de links para os seus respectivos sites.

1. Outwit

Outwit é um complemento para o Firefox, de fácil instalação através da loja de complementos do navegador.

- Esta ferramenta simplifica significativamente a coleta de informações de contato e e-mails na web.

- Existem três opções de aquisição, adaptadas às suas necessidades:

- Pró

- Expert

- Edição Enterprise.

- A extração de dados com o Outwit Hub não requer conhecimento de programação.

- É possível começar a raspar dados de centenas de páginas com apenas um clique.

2. ParseHub

ParseHub é outra excelente ferramenta gratuita para web scraping.

- Permite a limpeza de texto e HTML antes do download dos dados.

- A extração de dados é feita de forma intuitiva, selecionando os dados desejados.

- É possível armazenar os dados raspados em diversos formatos para análise posterior.

- Possui uma interface gráfica amigável.

- A ferramenta permite a coleta e o armazenamento automático de dados nos servidores.

3. Apify

Apify é uma ferramenta de automação e web scraping que possibilita a criação de APIs para qualquer site, com proxies residenciais e de data center integrados para facilitar a extração de dados.

- A Apify cuida da infraestrutura e faturamento, permitindo que desenvolvedores gerem renda passiva criando ferramentas para outros usuários.

- Possui conectores para Zapier, Integromat, Keboola e Airbyte.

- A Apify Store oferece soluções prontas para sites populares como Instagram, Facebook, Twitter e Google Maps.

- Os dados podem ser baixados em formatos estruturados como JSON, XML, CSV, HTML e Excel.

- O Apify Proxy oferece recursos como HTTPS, segmentação por geolocalização, rotação inteligente de IP e proxies SERP do Google.

- Oferece um teste gratuito de 30 dias com um crédito de plataforma de USD 5.

4. Scrapestack

O Scrapestack, utilizado por mais de 2.000 empresas, é uma API fornecida pela apilayer, sendo considerada uma das melhores ferramentas gratuitas para web scraping.

- Utiliza um pool global de 35 milhões de endereços IP de data centers.

- Permite a execução de várias solicitações de API simultaneamente.

- Suporta descriptografia CAPTCHA e renderização JavaScript.

- Oferece planos gratuitos e pagos.

- Scrapestack é uma API REST de raspagem online que opera em tempo real.

- Permite extrair páginas da web em milissegundos usando milhões de IPs de proxy, navegadores e CAPTCHAs.

- As solicitações de web scraping podem ser enviadas de mais de 100 locais diferentes ao redor do mundo.

5. FMiner

O FMiner é um programa popular para web scraping, extração de dados, raspagem de tela, macros e suporte à web, disponível para Windows e Mac OS.

- Permite a coleta de dados de sites dinâmicos da Web 2.0, que são mais difíceis de rastrear.

- Facilita a criação de projetos de extração de dados através de um editor visual simples de usar.

- Utiliza uma combinação de estruturas de links, menus suspensos e correspondência de padrões de URL para navegar nas páginas da web.

- Possibilita o uso de serviços decaptcha automáticos de terceiros ou entrada manual para lidar com a proteção CAPTCHA dos sites.

6. Sequentum

Sequentum é uma ferramenta robusta para big data, utilizada para obter dados online de forma confiável, sendo considerada uma das melhores ferramentas gratuitas de web scraping.

- A extração de dados online é mais rápida em comparação com soluções alternativas.

- Possibilita a transição entre várias plataformas.

- Inclui recursos simples, como um editor visual de apontar e clicar.

- Uma API web dedicada auxilia no desenvolvimento de aplicações, permitindo o uso de dados da web diretamente no seu site.

7. Agenty

Agenty é um programa de extração de dados, texto e OCR que utiliza automação de processos robóticos.

- Permite a reutilização de dados processados para fins de análise.

- A criação de agentes é feita com poucos cliques.

- Notifica por e-mail quando a tarefa é concluída.

- Possibilita a conexão com o Dropbox e o uso de FTP seguro.

- Disponibiliza todos os logs de atividade para visualização.

- Auxilia na otimização do desempenho da empresa.

- Facilita a implementação de regras de negócios e lógica personalizada.

8. Import.io

O aplicativo de web scraping import.io facilita a formação de conjuntos de dados, importando dados de uma página da web e exportando-os para CSV. É considerada uma das melhores ferramentas de web scraping, apresentando as seguintes características:

- Formulários e logins da web são simples de usar.

- É uma solução eficaz para integrar dados em aplicações através de APIs e webhooks.

- Permite obter insights através de relatórios, gráficos e visualizações.

- Possibilita o agendamento de extrações de dados.

- A nuvem Import.io possibilita o armazenamento e acesso aos dados.

- Automatiza interações com a web e fluxos de trabalho.

9. Webz.io

Webz.io permite o rastreamento de centenas de sites, oferecendo acesso imediato a dados estruturados em tempo real, sendo uma das melhores ferramentas gratuitas de web scraping.

É possível obter conjuntos de dados organizados e legíveis por máquina nos formatos JSON e XML.

- Oferece acesso a feeds históricos com dados de mais de dez anos.

- Permite acesso a um grande banco de dados de feeds de dados sem custos adicionais.

- Possibilita o uso de filtros avançados para análises detalhadas e alimentação de conjuntos de dados.

10. Scrapeowl

Scrape Owl é uma plataforma de web scraping de fácil utilização e custo acessível.

- Tem como objetivo principal a extração de dados de diversos tipos, incluindo e-commerce, quadros de empregos e listagens de imóveis.

- Possibilita a execução de JavaScript personalizado antes da extração do material.

- Permite a utilização de localizações geográficas para contornar restrições e acessar conteúdo local.

- Oferece uma função de espera confiável.

- Suporta a renderização JavaScript de páginas completas.

- Pode ser utilizado diretamente em Planilhas Google.

- Oferece um teste gratuito de 1000 créditos para experimentar o serviço antes da compra, sem necessidade de cartão de crédito.

11. Scrapingbee

Scrapingbee é uma API de web scraping que gerencia configurações de proxy e navegadores headless.

- Executa JavaScript nas páginas e rotaciona proxies para cada solicitação, permitindo a leitura do HTML bruto sem ser bloqueado.

- Disponibiliza uma segunda API para extrair resultados de pesquisa do Google.

- Suporta a renderização JavaScript.

- Possui um recurso de rotação de proxy automatizado.

- Pode ser utilizado diretamente no Planilhas Google.

- Requer o navegador Chrome para utilização.

- É ideal para raspagem de dados da Amazon.

- Permite a raspagem de resultados do Google.

12. Bright Data

Bright Data é uma plataforma líder de dados online, oferecendo soluções econômicas para coleta de dados públicos da web em larga escala, conversão de dados não estruturados em estruturados, além de proporcionar uma experiência superior ao cliente com total transparência e conformidade.

- Oferece soluções pré-fabricadas adaptáveis, expansíveis e ajustáveis.

- O Data Collector fornece um fluxo de dados automatizado e personalizado em um único painel.

- O suporte ao cliente funciona 24 horas por dia, sete dias por semana.

- Os conjuntos de dados são adaptados às necessidades da empresa, incluindo tendências de e-commerce, dados de redes sociais, inteligência de concorrentes e pesquisa de mercado.

- Permite que empresas foquem no core business, automatizando o acesso a dados confiáveis do setor.

- Utiliza soluções sem código, consumindo menos recursos.

- Oferece dados de alta qualidade, maior tempo de atividade, dados mais rápidos e melhor atendimento ao cliente.

13. Scraper API

A ferramenta Scraper API possibilita o gerenciamento de proxies, navegadores e CAPTCHAs.

- Oferece velocidade e confiabilidade, permitindo a criação de web scrapers escaláveis.

- Permite obter o HTML de qualquer página com uma única chamada de API.

- É simples de configurar, exigindo apenas o envio de uma solicitação GET com a chave de API e URL para o endpoint da API.

- Facilita a renderização de JavaScript.

- Possibilita a personalização do tipo de solicitação e cabeçalhos.

- Oferece proxies rotativos com localização geográfica.

14. Dexi Intelligent

Dexi intelligent é um aplicativo de raspagem online que permite transformar qualquer quantidade de dados da web em valor de negócio.

- Economiza tempo e dinheiro para a empresa.

- Melhora produtividade, precisão e qualidade.

- Permite uma extração de dados mais rápida e eficiente.

- Possui um sistema de captura de conhecimento em larga escala.

15. Diffbot

Diffbot permite obter rapidamente uma variedade de dados importantes da internet.

- Utiliza extratores de IA para extrair dados estruturados e precisos de qualquer URL.

- Não cobra por raspagens de sites demoradas ou consultas manuais.

- Mescla diversas fontes de dados para construir uma imagem completa e precisa de cada objeto.

- Oferece o Crawlbot para escalar a extração para milhares de domínios.

- Possui o recurso Knowledge Graph, que fornece dados precisos e completos para BI.

16. Data Streamer

Data Streamer é uma tecnologia que possibilita a obtenção de material de redes sociais em toda a internet.

- É um dos maiores raspadores online, utilizando processamento de linguagem natural para recuperar metadados importantes.

- Utiliza Kibana e Elasticsearch para fornecer pesquisa de texto completo integrada.

- Baseia-se em algoritmos de recuperação de informações, remoção integrada de clichês e extração de conteúdo.

- Construído em uma infraestrutura tolerante a falhas para alta disponibilidade de informações.

17. Mozenda

Mozenda permite a extração de texto, imagens e material PDF de páginas da web.

- Possibilita o uso da ferramenta ou banco de dados Bl de preferência para coletar e publicar dados online.

- Organiza e formata arquivos de dados para publicação.

- Permite criar agentes de web scraping em minutos com uma interface de apontar e clicar.

- Utiliza os recursos Sequenciador de tarefas e Bloqueio de solicitações para coletar dados em tempo real.

- Oferece gerenciamento de contas e atendimento ao cliente.

18. Extensão Chrome Data Miner

A captura de dados é facilitada pelo plugin do navegador Data Miner.

- Rastreia várias páginas e extrai dados dinamicamente.

- Oferece diversas formas de seleção de dados.

- Permite a verificação das informações raspadas.

- Os dados raspados podem ser salvos em formato CSV.

- Utiliza armazenamento local.

- O add-on do Chrome extrai dados de sites dinâmicos.

- Permite a importação e exportação de sitemaps.

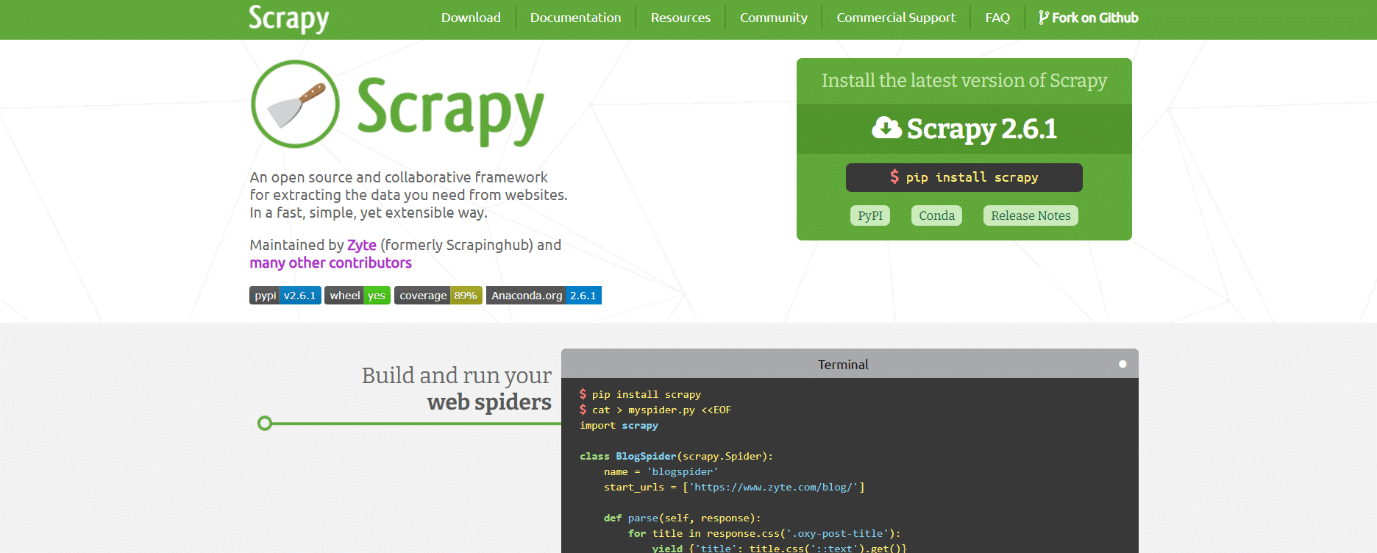

19. Scrapy

Scrapy é uma estrutura de raspagem online de código aberto baseada em Python para criação de web scrapers.

- Fornece todas as ferramentas necessárias para extrair, analisar e salvar rapidamente dados de sites na estrutura e formato desejado.

- É essencial para projetos de extração de dados de grande escala, oferecendo eficiência e flexibilidade.

- Os dados podem ser exportados em formatos JSON, CSV ou XML.

- Compatível com Linux, Mac OS X e Windows.

- É desenvolvido em cima da tecnologia de rede assíncrona Twisted.

- Destaca-se pela facilidade de uso, documentação extensa e comunidade ativa.

20. ScrapeHero Cloud

ScrapeHero transformou seus anos de experiência em rastreamento da web em crawlers e APIs pré-construídos, econômicos e fáceis de usar, para extração de dados de sites como Amazon, Google e Walmart.

- Os crawlers do ScrapeHero Cloud incluem proxies de rotação automática e a opção de executar vários crawlers simultaneamente.

- Não é necessário baixar ou aprender a usar ferramentas ou software de extração de dados.

- Os crawlers do ScrapeHero Cloud permitem coletar dados instantaneamente e exportá-los em formatos JSON, CSV ou Excel.

- Clientes dos planos Free e Lite recebem suporte por e-mail, enquanto outros planos têm serviço prioritário.

- Os crawlers ScrapeHero Cloud também podem ser configurados para atender a requisitos específicos do cliente.

- Funciona em qualquer navegador da web.

- Não exige conhecimento de programação, sendo tão fácil quanto clicar, copiar e colar.

21. Data Scraper

Data Scraper é um aplicativo de raspagem online gratuito que raspa dados de uma única página da web e salva em arquivos CSV ou XSL.

- É uma extensão do navegador que converte dados em um formato tabular puro.

- Requer a instalação do plugin no navegador Google Chrome.

- A versão gratuita permite raspar 500 páginas por mês; planos pagos permitem mais páginas.

22. Visual Web Ripper

Visual Web Ripper é uma ferramenta de raspagem automática de dados para sites.

- Coleta estruturas de dados de sites ou resultados de pesquisa.

- Exporta dados para arquivos CSV, XML e Excel, com uma interface amigável.

- Coleta dados de sites dinâmicos que usam AJAX.

- Requer apenas a configuração de alguns modelos, cuidando do resto.

- Oferece opções de agendamento e envia e-mail se um projeto falhar.

23. Octoparse

Octoparse é um aplicativo de raspagem de página da web fácil de usar, com uma interface visual, sendo considerada uma das melhores ferramentas gratuitas de web scraping. As características incluem:

- Interface de apontar e clicar simplifica a seleção de informações a serem extraídas de um site.

- Gerencia páginas da web estáticas e dinâmicas com AJAX, JavaScript, cookies e outros recursos.

- Serviços de nuvem avançados que permitem extrair grandes volumes de dados.

- As informações raspadas podem ser salvas como arquivos TXT, CSV, HTML ou XLSX.

- A versão gratuita permite construir até 10 crawlers; planos pagos incluem API e proxies IP anônimos.

24. Web Harvey

O raspador visual da Web do WebHarvey possui um navegador embutido para extrair dados de sites online, sendo uma das melhores ferramentas de web scraping. Suas características incluem:

- Interface de apontar e clicar simplifica a seleção de itens.

- Não requer a escrita de nenhum código.

- Dados podem ser salvos em arquivos CSV, JSON e XML ou em um banco de dados SQL.

- Oferece raspagem de categorias em vários níveis.

- Permite o uso de expressões regulares.

- Permite configurar servidores proxy para manter o IP oculto.

25. PySpider

PySpider é um rastreador da web baseado em Python, considerado uma das melhores ferramentas gratuitas de web scraping. Suas características incluem:

- Possui arquitetura distribuída e suporta páginas Javascript.

- Permite ter muitos rastreadores.

- Armazena dados em diversos back-ends, como MongoDB, MySQL, Redis, entre outros.

- Utiliza filas de mensagens como RabbitMQ, Beanstalk e Redis.

- Possui interface de usuário simples, permitindo alterar scripts, monitorar atividades e examinar resultados.

- As informações podem ser baixadas nos formatos JSON e CSV.

- Ideal para interfaces de usuário baseadas em site e sites com muito AJAX.

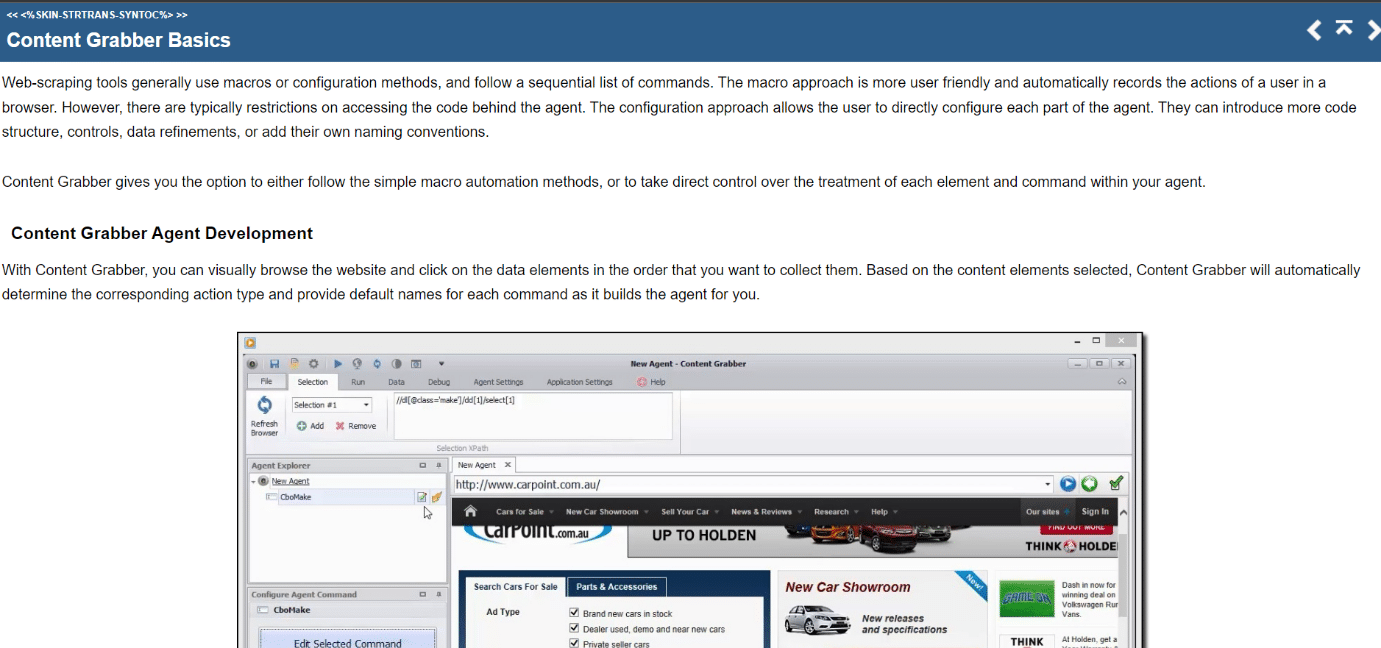

26. Content Grabber

Content Grabber é uma ferramenta de raspagem visual online com interface de apontar e clicar para seleção de itens. As características incluem:

- Exporta dados em formatos CSV, XLSX, JSON e PDF.

- Requer habilidades intermediárias de programação.

- Possibilita paginação, páginas de rolagem ilimitadas e pop-ups.

- Oferece processamento AJAX/Javascript, solução captcha, suporte a expressões regulares e rotação de IP (usando Nohodo).

27. Kimurai

Kimurai é um framework de web scraping Ruby para criação de scrapers e extração de dados, sendo uma das melhores ferramentas gratuitas de web scraping. As características incluem:

- Permite extrair e interagir com páginas da web produzidas por JavaScript com Headless Chromium/Firefox, PhantomJS ou consultas HTTP básicas.

- Possui sintaxe semelhante ao Scrapy e opções configuráveis.

- Interage com páginas da web usando a estrutura de teste Capybara.

28. Cheerio

Cheerio é um pacote que analisa documentos HTML e XML, permitindo operar com os dados baixados usando a sintaxe jQuery.

- Oferece uma opção rápida para análise, modificação e exibição de dados em web scrapers JavaScript.

- Não renderiza a saída em um navegador, aplica CSS, carrega recursos externos ou executa JavaScript.

- Em caso de necessidade dessas funcionalidades, PhantomJS ou JSDom podem ser utilizados.

29. Puppeteer

Puppeteer é um pacote Node que permite gerenciar o navegador Chrome headless usando uma API poderosa e simples. As características incluem:

- Executa comandos através de uma API em segundo plano.

- Utiliza um navegador headless (sem interface gráfica) capaz de enviar e receber solicitações.

- Ideal para informações geradas utilizando dados de API e código Javascript.

- Permite imitar a experiência do usuário com cliques e digitação.

- Captura telas de páginas da web.

30. Playwright

Playwright é uma biblioteca do Microsoft Node projetada para automação de navegadores, sendo uma das melhores ferramentas gratuitas de web scraping. As características incluem:

- Oferece automação da web eficiente, confiável e rápida entre navegadores.

- Melhora os testes automatizados de interface do usuário removendo falhas, aumentando a velocidade de execução e fornecendo informações sobre como o navegador funciona.

- É comparável ao Puppeteer em diversas formas, com navegadores compatíveis pré-instalados.

- Sua principal vantagem é a compatibilidade entre navegadores, suportando Chromium, WebKit e Firefox.

- Integra-se com Docker, Azure, Travis CI e AppVeyor.

31. PJScrape

PJscrape é um kit de ferramentas de raspagem online baseado em Python que utiliza Javascript e JQuery. As características incluem:

- Funciona com o PhantomJS, permitindo extrair sites da linha de comando em um contexto habilitado para Javascript, sem necessidade de navegador.

- Permite o acesso ao DOM, variáveis e funções Javascript, bem como conteúdo carregado em AJAX.

- As funções do raspador são avaliadas no contexto de todo o navegador.

***

Esperamos que este guia sobre as melhores ferramentas de web scraping tenha sido útil. Compartilhe conosco qual ferramenta você considera mais fácil de usar. Continue visitando nossa página para mais dicas e deixe seus comentários abaixo.